mirror of

https://github.com/apachecn/ailearning.git

synced 2026-02-03 02:14:18 +08:00

2020-10-19 20:56:03

This commit is contained in:

34

SUMMARY.md

34

SUMMARY.md

@@ -1,24 +1,24 @@

|

||||

|

||||

+ [入门须知](README.md)

|

||||

+ 机器学习

|

||||

+ [第1章_基础知识](docs/ml/1.机器学习基础.md)

|

||||

+ [第2章_K近邻算法](docs/ml/2.k-近邻算法.md)

|

||||

+ [第3章_决策树算法](docs/ml/3.决策树.md)

|

||||

+ [第4章_朴素贝叶斯](docs/ml/4.朴素贝叶斯.md)

|

||||

+ [第5章_逻辑回归](docs/ml/5.Logistic回归.md)

|

||||

+ [第6章_支持向量机](docs/ml/6.支持向量机.md)

|

||||

+ [第7章_集成方法](docs/ml/7.集成方法-随机森林和AdaBoost.md)

|

||||

+ [第8章_回归](docs/ml/8.回归.md)

|

||||

+ [第9章_树回归](docs/ml/9.树回归.md)

|

||||

+ [第10章_KMeans聚类](docs/ml/10.KMeans聚类.md)

|

||||

+ [第11章_Apriori算法](docs/ml/11.使用Apriori算法进行关联分析.md)

|

||||

+ [第12章_FP-growth算法](docs/ml/12.使用FP-growth算法来高效发现频繁项集.md)

|

||||

+ [第13章_PCA降维](docs/ml/13.利用PCA来简化数据.md)

|

||||

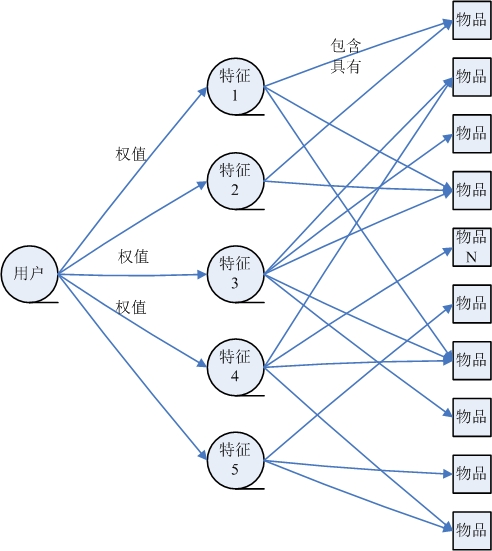

+ [第14章_SVD简化数据](docs/ml/14.利用SVD简化数据.md)

|

||||

+ [第15章_大数据与MapReduce](docs/ml/15.大数据与MapReduce.md)

|

||||

+ [第16章_推荐系统](docs/ml/16.推荐系统.md)

|

||||

+ [第1章_基础知识](docs/ml/1.md)

|

||||

+ [第2章_K近邻算法](docs/ml/2.md)

|

||||

+ [第3章_决策树算法](docs/ml/3.md)

|

||||

+ [第4章_朴素贝叶斯](docs/ml/4.md)

|

||||

+ [第5章_逻辑回归](docs/ml/5.md)

|

||||

+ [第6章_支持向量机](docs/ml/6.md)

|

||||

+ [第7章_集成方法](docs/ml/7.md)

|

||||

+ [第8章_回归](docs/ml/8.md)

|

||||

+ [第9章_树回归](docs/ml/9.md)

|

||||

+ [第10章_KMeans聚类](docs/ml/10.md)

|

||||

+ [第11章_Apriori算法](docs/ml/11.md)

|

||||

+ [第12章_FP-growth算法](docs/ml/12.md)

|

||||

+ [第13章_PCA降维](docs/ml/13.md)

|

||||

+ [第14章_SVD简化数据](docs/ml/14.md)

|

||||

+ [第15章_大数据与MapReduce](docs/ml/15.md)

|

||||

+ [第16章_推荐系统](docs/ml/16.md)

|

||||

+ [为何录制教学版视频](docs/why-to-record-study-ml-video.md)

|

||||

+ [2017-04-08_第一期的总结](report/2017-04-08_第一期的总结.md)

|

||||

+ [2017-04-08_第一期的总结](docs/report/2017-04-08.md)

|

||||

+ 深度学习入门

|

||||

+ [反向传递](docs/dl/反向传递.md)

|

||||

+ [CNN原理](docs/dl/CNN原理.md)

|

||||

|

||||

@@ -1,239 +1,239 @@

|

||||

# 第1章 机器学习基础

|

||||

|

||||

|

||||

|

||||

## 机器学习 概述

|

||||

|

||||

`机器学习(Machine Learning,ML)` 是使用计算机来彰显数据背后的真实含义,它为了把无序的数据转换成有用的信息。是一门多领域交叉学科,涉及概率论、统计学、逼近论、凸分析、算法复杂度理论等多门学科。专门研究计算机怎样模拟或实现人类的学习行为,以获取新的知识或技能,重新组织已有的知识结构使之不断改善自身的性能。

|

||||

它是人工智能的核心,是使计算机具有智能的根本途径,其应用遍及人工智能的各个领域,它主要使用归纳、综合而不是演绎。

|

||||

|

||||

1. 海量的数据

|

||||

2. 获取有用的信息

|

||||

|

||||

## 机器学习 研究意义

|

||||

|

||||

机器学习是一门人工智能的科学,该领域的主要研究对象是人工智能,特别是如何在经验学习中改善具体算法的性能”。 “机器学习是对能通过经验自动改进的计算机算法的研究”。 “机器学习是用数据或以往的经验,以此优化计算机程序的性能标准。” 一种经常引用的英文定义是: A computer program is said to learn from experience E with respect to some class of tasks T and performance measure P, if its performance at tasks in T, as measured by P, improves with experience E.

|

||||

|

||||

机器学习已经有了十分广泛的应用,例如: 数据挖掘、计算机视觉、自然语言处理、生物特征识别、搜索引擎、医学诊断、检测信用卡欺诈、证券市场分析、DNA序列测序、语音和手写识别、战略游戏和机器人运用。

|

||||

## 机器学习 场景

|

||||

|

||||

* 例如: 识别动物猫

|

||||

* 模式识别(官方标准): 人们通过大量的经验,得到结论,从而判断它就是猫。

|

||||

* 机器学习(数据学习): 人们通过阅读进行学习,观察它会叫、小眼睛、两只耳朵、四条腿、一条尾巴,得到结论,从而判断它就是猫。

|

||||

* 深度学习(深入数据): 人们通过深入了解它,发现它会'喵喵'的叫、与同类的猫科动物很类似,得到结论,从而判断它就是猫。(深度学习常用领域: 语音识别、图像识别)

|

||||

|

||||

* 模式识别(pattern recognition): 模式识别是最古老的(作为一个术语而言,可以说是很过时的)。

|

||||

* 我们把环境与客体统称为“模式”,识别是对模式的一种认知,是如何让一个计算机程序去做一些看起来很“智能”的事情。

|

||||

* 通过融于智慧和直觉后,通过构建程序,识别一些事物,而不是人,例如: 识别数字。

|

||||

* 机器学习(machine learning): 机器学习是最基础的(当下初创公司和研究实验室的热点领域之一)。

|

||||

* 在90年代初,人们开始意识到一种可以更有效地构建模式识别算法的方法,那就是用数据(可以通过廉价劳动力采集获得)去替换专家(具有很多图像方面知识的人)。

|

||||

* “机器学习”强调的是,在给计算机程序(或者机器)输入一些数据后,它必须做一些事情,那就是学习这些数据,而这个学习的步骤是明确的。

|

||||

* 机器学习(Machine Learning)是一门专门研究计算机怎样模拟或实现人类的学习行为,以获取新的知识或技能,重新组织已有的知识结构使之不断改善自身性能的学科。

|

||||

* 深度学习(deep learning): 深度学习是非常崭新和有影响力的前沿领域,我们甚至不会去思考-后深度学习时代。

|

||||

* 深度学习是机器学习研究中的一个新的领域,其动机在于建立、模拟人脑进行分析学习的神经网络,它模仿人脑的机制来解释数据,例如图像,声音和文本。

|

||||

|

||||

* 参考地址:

|

||||

* [深度学习 vs 机器学习 vs 模式识别](http://www.csdn.net/article/2015-03-24/2824301)

|

||||

* [深度学习 百科资料](http://baike.baidu.com/link?url=76P-uA4EBrC3G-I__P1tqeO7eoDS709Kp4wYuHxc7GNkz_xn0NxuAtEohbpey7LUa2zUQLJxvIKUx4bnrEfOmsWLKbDmvG1PCoRkJisMTQka6-QReTrIxdYY3v93f55q)

|

||||

|

||||

|

||||

> 机器学习已应用于多个领域,远远超出大多数人的想象,横跨: 计算机科学、工程技术和统计学等多个学科。

|

||||

|

||||

* 搜索引擎: 根据你的搜索点击,优化你下次的搜索结果,是机器学习来帮助搜索引擎判断哪个结果更适合你(也判断哪个广告更适合你)。

|

||||

* 垃圾邮件: 会自动的过滤垃圾广告邮件到垃圾箱内。

|

||||

* 超市优惠券: 你会发现,你在购买小孩子尿布的时候,售货员会赠送你一张优惠券可以兑换6罐啤酒。

|

||||

* 邮局邮寄: 手写软件自动识别寄送贺卡的地址。

|

||||

* 申请贷款: 通过你最近的金融活动信息进行综合评定,决定你是否合格。

|

||||

|

||||

|

||||

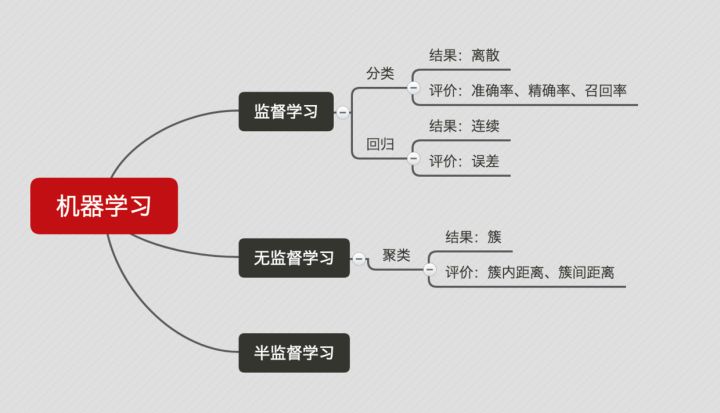

## 机器学习 组成

|

||||

|

||||

### 主要任务

|

||||

|

||||

* 分类(classification): 将实例数据划分到合适的类别中。

|

||||

* 应用实例: 判断网站是否被黑客入侵(二分类 ),手写数字的自动识别(多分类)

|

||||

* 回归(regression): 主要用于预测数值型数据。

|

||||

* 应用实例: 股票价格波动的预测,房屋价格的预测等。

|

||||

|

||||

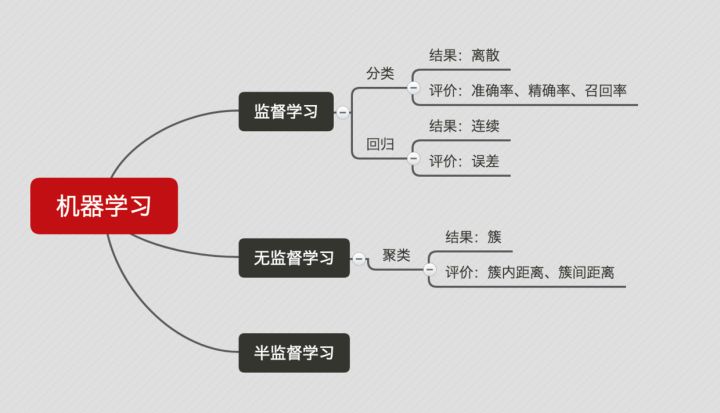

### 监督学习(supervised learning)

|

||||

|

||||

* 必须确定目标变量的值,以便机器学习算法可以发现特征和目标变量之间的关系。在监督学习中,给定一组数据,我们知道正确的输出结果应该是什么样子,并且知道在输入和输出之间有着一个特定的关系。 (包括: 分类和回归)

|

||||

* 样本集: 训练数据 + 测试数据

|

||||

* 训练样本 = 特征(feature) + 目标变量(label: 分类-离散值/回归-连续值)

|

||||

* 特征通常是训练样本集的列,它们是独立测量得到的。

|

||||

* 目标变量: 目标变量是机器学习预测算法的测试结果。

|

||||

* 在分类算法中目标变量的类型通常是标称型(如: 真与假),而在回归算法中通常是连续型(如: 1~100)。

|

||||

* 监督学习需要注意的问题:

|

||||

* 偏置方差权衡

|

||||

* 功能的复杂性和数量的训练数据

|

||||

* 输入空间的维数

|

||||

* 噪声中的输出值

|

||||

* `知识表示`:

|

||||

* 可以采用规则集的形式【例如: 数学成绩大于90分为优秀】

|

||||

* 可以采用概率分布的形式【例如: 通过统计分布发现,90%的同学数学成绩,在70分以下,那么大于70分定为优秀】

|

||||

* 可以使用训练样本集中的一个实例【例如: 通过样本集合,我们训练出一个模型实例,得出 年轻,数学成绩中高等,谈吐优雅,我们认为是优秀】

|

||||

|

||||

### 非监督学习(unsupervised learning)

|

||||

|

||||

* 在机器学习,无监督学习的问题是,在未加标签的数据中,试图找到隐藏的结构。因为提供给学习者的实例是未标记的,因此没有错误或报酬信号来评估潜在的解决方案。

|

||||

* 无监督学习是密切相关的统计数据密度估计的问题。然而无监督学习还包括寻求,总结和解释数据的主要特点等诸多技术。在无监督学习使用的许多方法是基于用于处理数据的数据挖掘方法。

|

||||

* 数据没有类别信息,也不会给定目标值。

|

||||

* 非监督学习包括的类型:

|

||||

* 聚类: 在无监督学习中,将数据集分成由类似的对象组成多个类的过程称为聚类。

|

||||

* 密度估计: 通过样本分布的紧密程度,来估计与分组的相似性。

|

||||

* 此外,无监督学习还可以减少数据特征的维度,以便我们可以使用二维或三维图形更加直观地展示数据信息。

|

||||

### 强化学习

|

||||

这个算法可以训练程序做出某一决定。程序在某一情况下尝试所有的可能行动,记录不同行动的结果并试着找出最好的一次尝试来做决定。 属于这一类算法的有马尔可夫决策过程。

|

||||

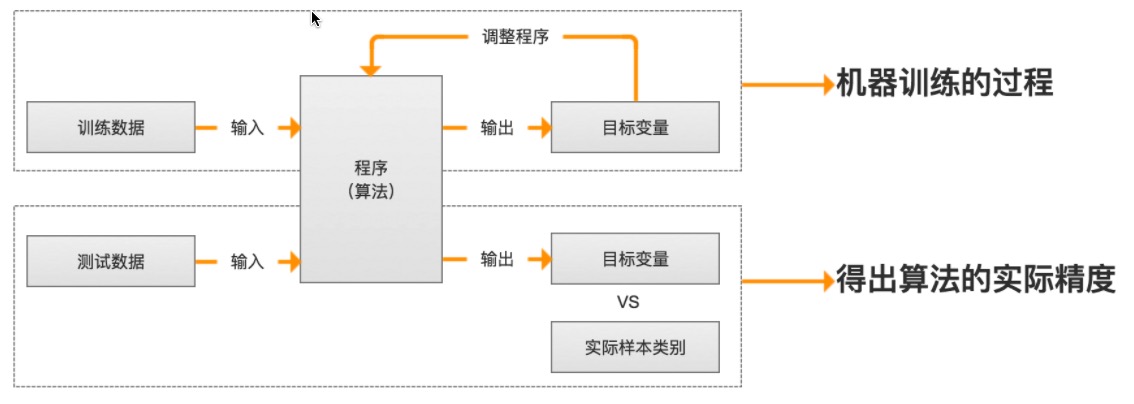

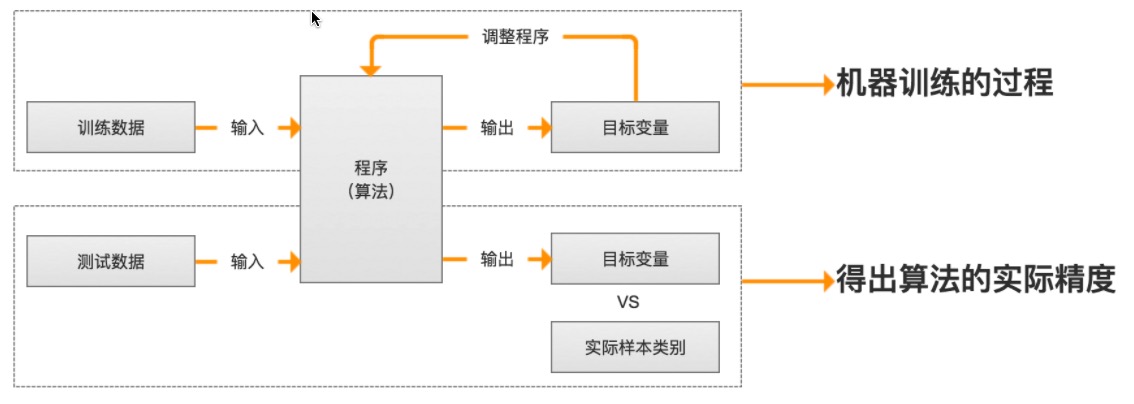

### 训练过程

|

||||

|

||||

|

||||

|

||||

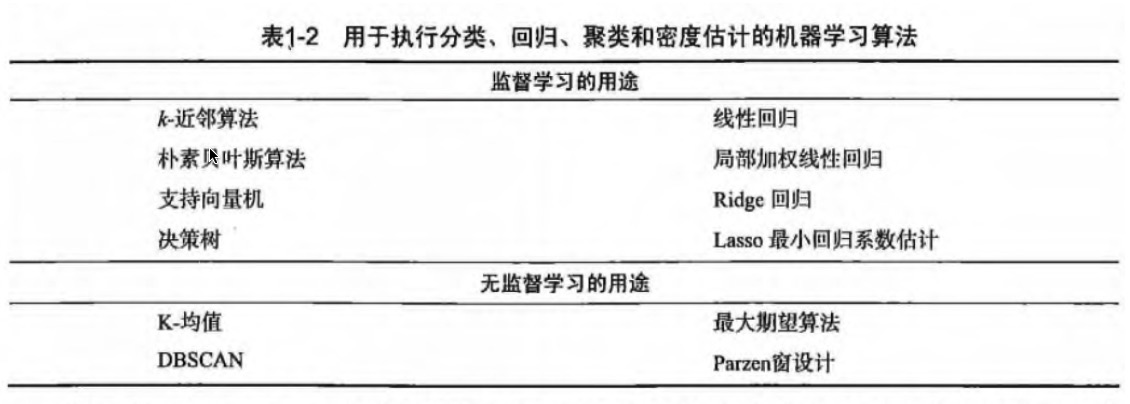

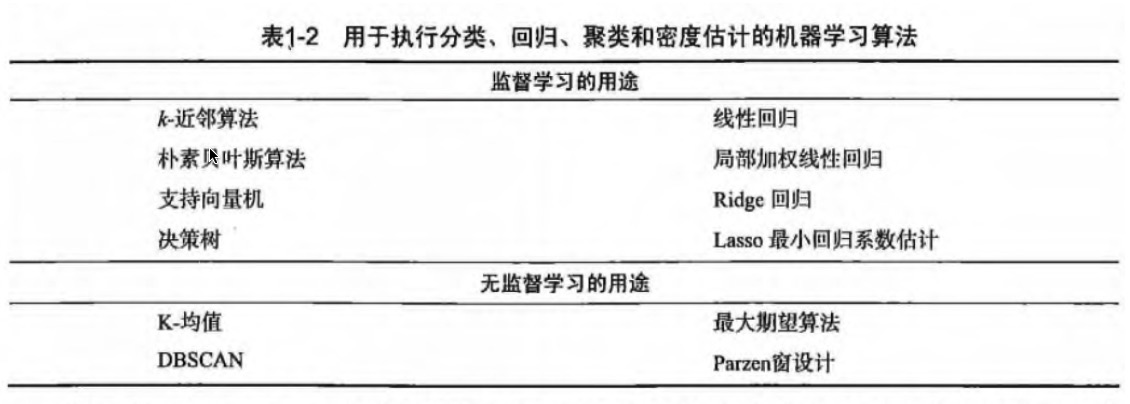

### 算法汇总

|

||||

|

||||

|

||||

|

||||

|

||||

## 机器学习 使用

|

||||

|

||||

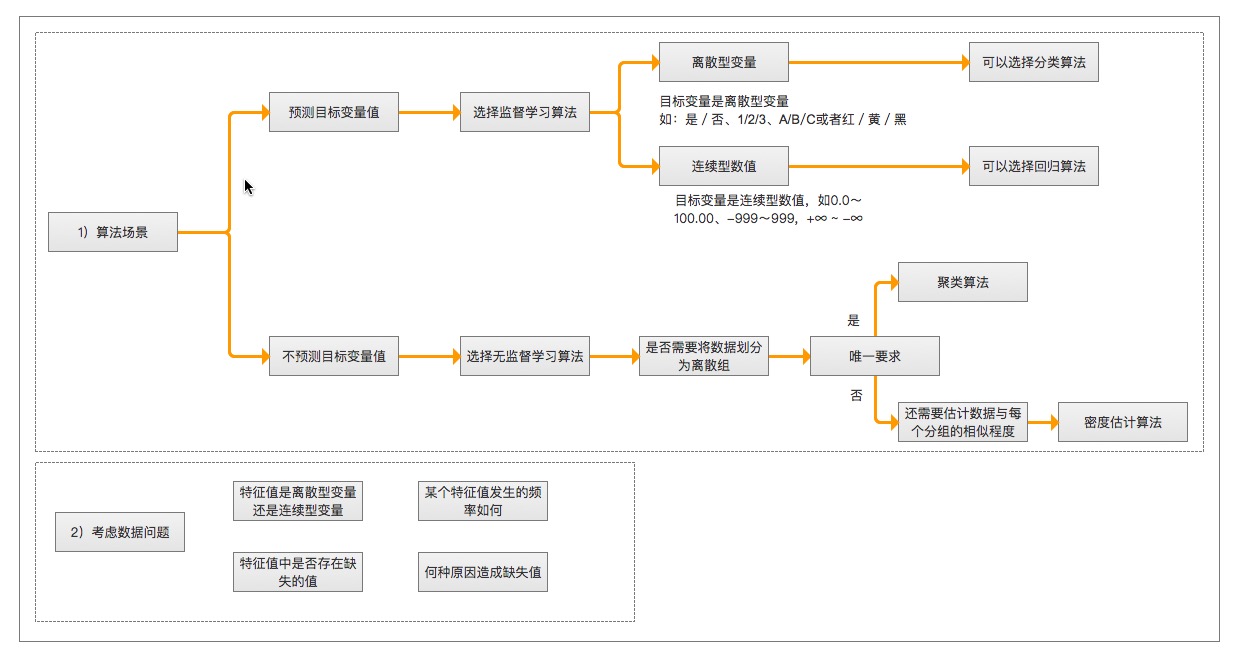

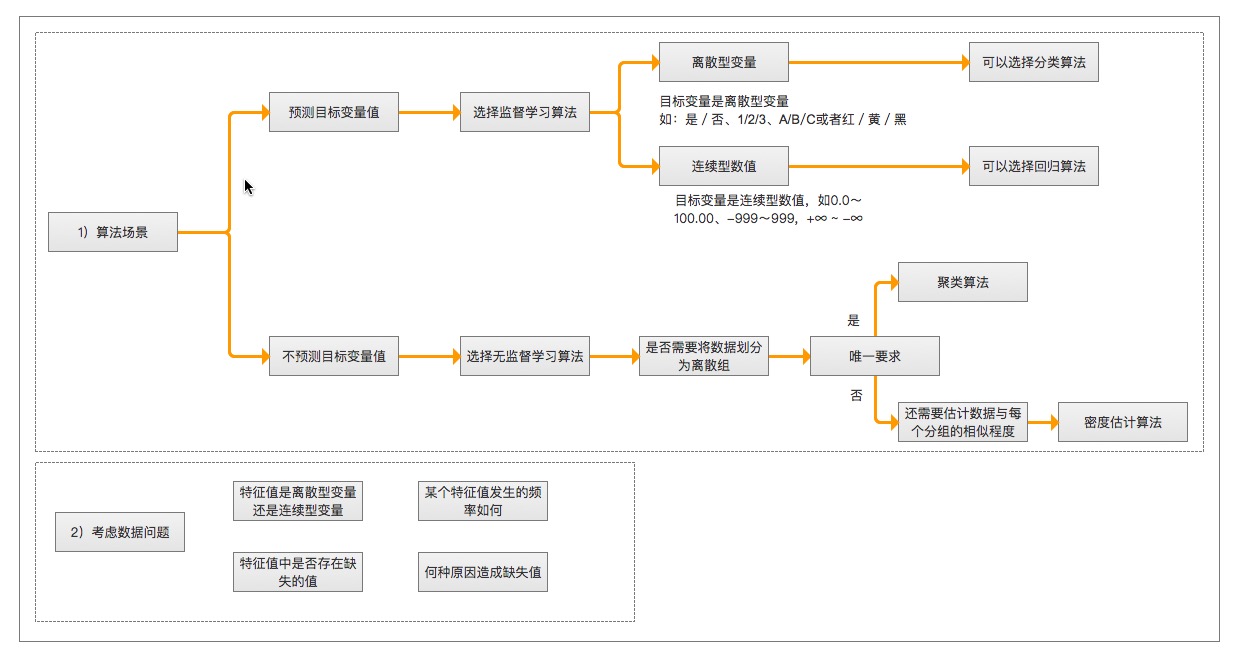

> 选择算法需要考虑的两个问题

|

||||

|

||||

1. 算法场景

|

||||

* 预测明天是否下雨,因为可以用历史的天气情况做预测,所以选择监督学习算法

|

||||

* 给一群陌生的人进行分组,但是我们并没有这些人的类别信息,所以选择无监督学习算法、通过他们身高、体重等特征进行处理。

|

||||

2. 需要收集或分析的数据是什么

|

||||

|

||||

> 举例

|

||||

|

||||

|

||||

|

||||

> 机器学习 开发流程

|

||||

|

||||

|

||||

1. 收集数据: 收集样本数据

|

||||

2. 准备数据: 注意数据的格式

|

||||

3. 分析数据: 为了确保数据集中没有垃圾数据;

|

||||

* 如果是算法可以处理的数据格式或可信任的数据源,则可以跳过该步骤;

|

||||

* 另外该步骤需要人工干预,会降低自动化系统的价值。

|

||||

4. 训练算法: [机器学习算法核心]如果使用无监督学习算法,由于不存在目标变量值,则可以跳过该步骤

|

||||

5. 测试算法: [机器学习算法核心]评估算法效果

|

||||

6. 使用算法: 将机器学习算法转为应用程序

|

||||

|

||||

## 机器学习 数学基础

|

||||

* 微积分

|

||||

* 统计学/概率论

|

||||

* 线性代数

|

||||

## 机器学习 工具

|

||||

|

||||

### Python语言

|

||||

|

||||

1. 可执行伪代码

|

||||

2. Python比较流行: 使用广泛、代码范例多、丰富模块库,开发周期短

|

||||

3. Python语言的特色: 清晰简练、易于理解

|

||||

4. Python语言的缺点: 唯一不足的是性能问题

|

||||

5. Python相关的库

|

||||

* 科学函数库: `SciPy`、`NumPy`(底层语言: C和Fortran)

|

||||

* 绘图工具库: `Matplotlib`

|

||||

* 数据分析库 `Pandas`

|

||||

### 数学工具

|

||||

* Matlab

|

||||

## 附: 机器学习专业术语

|

||||

* 模型(model): 计算机层面的认知

|

||||

* 学习算法(learning algorithm),从数据中产生模型的方法

|

||||

* 数据集(data set): 一组记录的合集

|

||||

* 示例(instance): 对于某个对象的描述

|

||||

* 样本(sample): 也叫示例

|

||||

* 属性(attribute): 对象的某方面表现或特征

|

||||

* 特征(feature): 同属性

|

||||

* 属性值(attribute value): 属性上的取值

|

||||

* 属性空间(attribute space): 属性张成的空间

|

||||

* 样本空间/输入空间(samplespace): 同属性空间

|

||||

* 特征向量(feature vector): 在属性空间里每个点对应一个坐标向量,把一个示例称作特征向量

|

||||

* 维数(dimensionality): 描述样本参数的个数(也就是空间是几维的)

|

||||

* 学习(learning)/训练(training): 从数据中学得模型

|

||||

* 训练数据(training data): 训练过程中用到的数据

|

||||

* 训练样本(training sample):训练用到的每个样本

|

||||

* 训练集(training set): 训练样本组成的集合

|

||||

* 假设(hypothesis): 学习模型对应了关于数据的某种潜在规则

|

||||

* 真相(ground-truth):真正存在的潜在规律

|

||||

* 学习器(learner): 模型的另一种叫法,把学习算法在给定数据和参数空间的实例化

|

||||

* 预测(prediction): 判断一个东西的属性

|

||||

* 标记(label): 关于示例的结果信息,比如我是一个“好人”。

|

||||

* 样例(example): 拥有标记的示例

|

||||

* 标记空间/输出空间(label space): 所有标记的集合

|

||||

* 分类(classification): 预测是离散值,比如把人分为好人和坏人之类的学习任务

|

||||

* 回归(regression): 预测值是连续值,比如你的好人程度达到了0.9,0.6之类的

|

||||

* 二分类(binary classification): 只涉及两个类别的分类任务

|

||||

* 正类(positive class): 二分类里的一个

|

||||

* 反类(negative class): 二分类里的另外一个

|

||||

* 多分类(multi-class classification): 涉及多个类别的分类

|

||||

* 测试(testing): 学习到模型之后对样本进行预测的过程

|

||||

* 测试样本(testing sample): 被预测的样本

|

||||

* 聚类(clustering): 把训练集中的对象分为若干组

|

||||

* 簇(cluster): 每一个组叫簇

|

||||

* 监督学习(supervised learning): 典范--分类和回归

|

||||

* 无监督学习(unsupervised learning): 典范--聚类

|

||||

* 未见示例(unseen instance): “新样本“,没训练过的样本

|

||||

* 泛化(generalization)能力: 学得的模型适用于新样本的能力

|

||||

* 分布(distribution): 样本空间的全体样本服从的一种规律

|

||||

* 独立同分布(independent and identically distributed,简称i,i,d.):获得的每个样本都是独立地从这个分布上采样获得的。

|

||||

|

||||

## 机器学习基础补充

|

||||

|

||||

### 数据集的划分

|

||||

|

||||

* 训练集(Training set) —— 学习样本数据集,通过匹配一些参数来建立一个模型,主要用来训练模型。类比考研前做的解题大全。

|

||||

* 验证集(validation set) —— 对学习出来的模型,调整模型的参数,如在神经网络中选择隐藏单元数。验证集还用来确定网络结构或者控制模型复杂程度的参数。类比 考研之前做的模拟考试。

|

||||

* 测试集(Test set) —— 测试训练好的模型的分辨能力。类比 考研。这次真的是一考定终身。

|

||||

|

||||

### 模型拟合程度

|

||||

|

||||

* 欠拟合(Underfitting): 模型没有很好地捕捉到数据特征,不能够很好地拟合数据,对训练样本的一般性质尚未学好。类比,光看书不做题觉得自己什么都会了,上了考场才知道自己啥都不会。

|

||||

* 过拟合(Overfitting): 模型把训练样本学习“太好了”,可能把一些训练样本自身的特性当做了所有潜在样本都有的一般性质,导致泛化能力下降。类比,做课后题全都做对了,超纲题也都认为是考试必考题目,上了考场还是啥都不会。

|

||||

|

||||

通俗来说,欠拟合和过拟合都可以用一句话来说,欠拟合就是: “你太天真了!”,过拟合就是: “你想太多了!”。

|

||||

|

||||

### 常见的模型指标

|

||||

|

||||

* 正确率 —— 提取出的正确信息条数 / 提取出的信息条数

|

||||

* 召回率 —— 提取出的正确信息条数 / 样本中的信息条数

|

||||

* F 值 —— 正确率 * 召回率 * 2 / (正确率 + 召回率)(F值即为正确率和召回率的调和平均值)

|

||||

|

||||

举个例子如下:

|

||||

|

||||

举个例子如下:

|

||||

某池塘有 1400 条鲤鱼,300 只虾,300 只乌龟。现在以捕鲤鱼为目的。撒了一张网,逮住了 700 条鲤鱼,200 只

|

||||

虾, 100 只乌龟。那么这些指标分别如下:

|

||||

正确率 = 700 / (700 + 200 + 100) = 70%

|

||||

召回率 = 700 / 1400 = 50%

|

||||

F 值 = 70% * 50% * 2 / (70% + 50%) = 58.3%

|

||||

|

||||

### 模型

|

||||

|

||||

* 分类问题 —— 说白了就是将一些未知类别的数据分到现在已知的类别中去。比如,根据你的一些信息,判断你是高富帅,还是穷屌丝。评判分类效果好坏的三个指标就是上面介绍的三个指标: 正确率,召回率,F值。

|

||||

* 回归问题 —— 对数值型连续随机变量进行预测和建模的监督学习算法。回归往往会通过计算 误差(Error)来确定模型的精确性。

|

||||

* 聚类问题 —— 聚类是一种无监督学习任务,该算法基于数据的内部结构寻找观察样本的自然族群(即集群)。聚类问题的标准一般基于距离: 簇内距离(Intra-cluster Distance) 和 簇间距离(Inter-cluster Distance) 。簇内距离是越小越好,也就是簇内的元素越相似越好;而簇间距离越大越好,也就是说簇间(不同簇)元素越不相同越好。一般的,衡量聚类问题会给出一个结合簇内距离和簇间距离的公式。

|

||||

|

||||

下面这个图可以比较直观地展示出来:

|

||||

|

||||

|

||||

|

||||

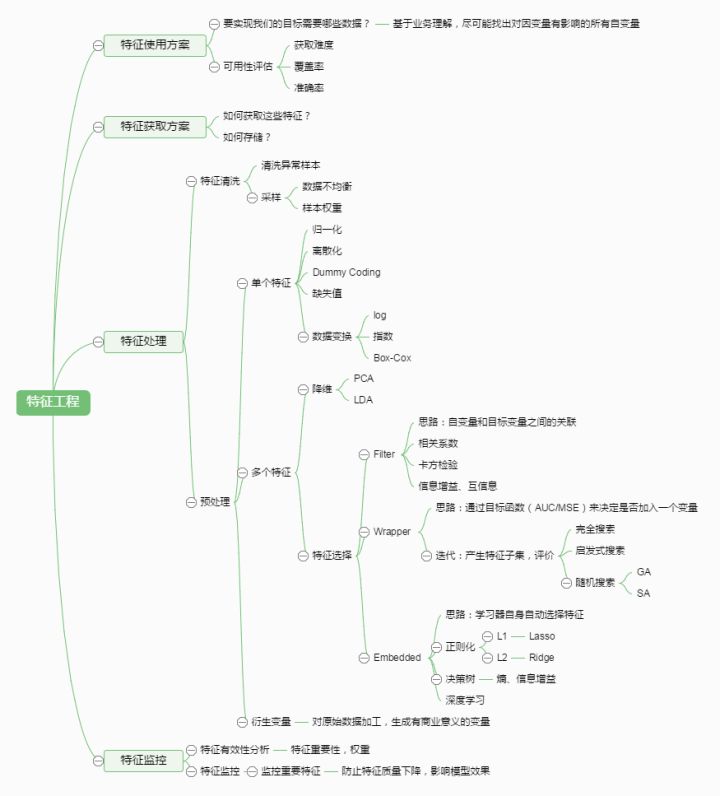

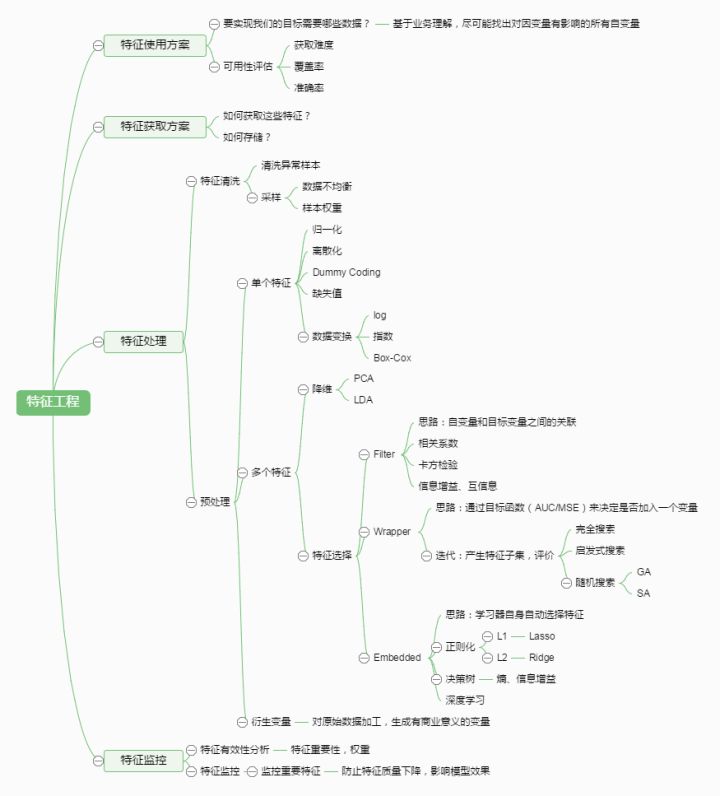

### 特征工程的一些小东西

|

||||

|

||||

* 特征选择 —— 也叫特征子集选择(FSS,Feature Subset Selection)。是指从已有的 M 个特征(Feature)中选择 N 个特征使得系统的特定指标最优化,是从原始特征中选择出一些最有效特征以降低数据集维度的过程,是提高算法性能的一个重要手段,也是模式识别中关键的数据预处理步骤。

|

||||

|

||||

* 特征提取 —— 特征提取是计算机视觉和图像处理中的一个概念。它指的是使用计算机提取图像信息,决定每个图像的点是否属于一个图像特征。特征提取的结果是把图像上的点分为不同的子集,这些子集往往属于孤立的点,连续的曲线或者连续的区域。

|

||||

|

||||

下面给出一个特征工程的图:

|

||||

|

||||

|

||||

|

||||

### 其他

|

||||

|

||||

* Learning rate —— 学习率,通俗地理解,可以理解为步长,步子大了,很容易错过最佳结果。就是本来目标尽在咫尺,可是因为我迈的步子很大,却一下子走过了。步子小了呢,就是同样的距离,我却要走很多很多步,这样导致训练的耗时费力还不讨好。

|

||||

* 一个总结的知识点很棒的链接 : https://zhuanlan.zhihu.com/p/25197792

|

||||

|

||||

* * *

|

||||

|

||||

* **作者: [片刻](http://cwiki.apachecn.org/display/~jiangzhonglian) [1988](http://cwiki.apachecn.org/display/~lihuisong)**

|

||||

* [GitHub地址](https://github.com/apachecn/AiLearning): <https://github.com/apachecn/AiLearning>

|

||||

* **版权声明: 欢迎转载学习 => 请标注信息来源于 [ApacheCN](http://www.apachecn.org/)**

|

||||

# 第1章 机器学习基础

|

||||

|

||||

|

||||

|

||||

## 机器学习 概述

|

||||

|

||||

`机器学习(Machine Learning,ML)` 是使用计算机来彰显数据背后的真实含义,它为了把无序的数据转换成有用的信息。是一门多领域交叉学科,涉及概率论、统计学、逼近论、凸分析、算法复杂度理论等多门学科。专门研究计算机怎样模拟或实现人类的学习行为,以获取新的知识或技能,重新组织已有的知识结构使之不断改善自身的性能。

|

||||

它是人工智能的核心,是使计算机具有智能的根本途径,其应用遍及人工智能的各个领域,它主要使用归纳、综合而不是演绎。

|

||||

|

||||

1. 海量的数据

|

||||

2. 获取有用的信息

|

||||

|

||||

## 机器学习 研究意义

|

||||

|

||||

机器学习是一门人工智能的科学,该领域的主要研究对象是人工智能,特别是如何在经验学习中改善具体算法的性能”。 “机器学习是对能通过经验自动改进的计算机算法的研究”。 “机器学习是用数据或以往的经验,以此优化计算机程序的性能标准。” 一种经常引用的英文定义是: A computer program is said to learn from experience E with respect to some class of tasks T and performance measure P, if its performance at tasks in T, as measured by P, improves with experience E.

|

||||

|

||||

机器学习已经有了十分广泛的应用,例如: 数据挖掘、计算机视觉、自然语言处理、生物特征识别、搜索引擎、医学诊断、检测信用卡欺诈、证券市场分析、DNA序列测序、语音和手写识别、战略游戏和机器人运用。

|

||||

## 机器学习 场景

|

||||

|

||||

* 例如: 识别动物猫

|

||||

* 模式识别(官方标准): 人们通过大量的经验,得到结论,从而判断它就是猫。

|

||||

* 机器学习(数据学习): 人们通过阅读进行学习,观察它会叫、小眼睛、两只耳朵、四条腿、一条尾巴,得到结论,从而判断它就是猫。

|

||||

* 深度学习(深入数据): 人们通过深入了解它,发现它会'喵喵'的叫、与同类的猫科动物很类似,得到结论,从而判断它就是猫。(深度学习常用领域: 语音识别、图像识别)

|

||||

|

||||

* 模式识别(pattern recognition): 模式识别是最古老的(作为一个术语而言,可以说是很过时的)。

|

||||

* 我们把环境与客体统称为“模式”,识别是对模式的一种认知,是如何让一个计算机程序去做一些看起来很“智能”的事情。

|

||||

* 通过融于智慧和直觉后,通过构建程序,识别一些事物,而不是人,例如: 识别数字。

|

||||

* 机器学习(machine learning): 机器学习是最基础的(当下初创公司和研究实验室的热点领域之一)。

|

||||

* 在90年代初,人们开始意识到一种可以更有效地构建模式识别算法的方法,那就是用数据(可以通过廉价劳动力采集获得)去替换专家(具有很多图像方面知识的人)。

|

||||

* “机器学习”强调的是,在给计算机程序(或者机器)输入一些数据后,它必须做一些事情,那就是学习这些数据,而这个学习的步骤是明确的。

|

||||

* 机器学习(Machine Learning)是一门专门研究计算机怎样模拟或实现人类的学习行为,以获取新的知识或技能,重新组织已有的知识结构使之不断改善自身性能的学科。

|

||||

* 深度学习(deep learning): 深度学习是非常崭新和有影响力的前沿领域,我们甚至不会去思考-后深度学习时代。

|

||||

* 深度学习是机器学习研究中的一个新的领域,其动机在于建立、模拟人脑进行分析学习的神经网络,它模仿人脑的机制来解释数据,例如图像,声音和文本。

|

||||

|

||||

* 参考地址:

|

||||

* [深度学习 vs 机器学习 vs 模式识别](http://www.csdn.net/article/2015-03-24/2824301)

|

||||

* [深度学习 百科资料](http://baike.baidu.com/link?url=76P-uA4EBrC3G-I__P1tqeO7eoDS709Kp4wYuHxc7GNkz_xn0NxuAtEohbpey7LUa2zUQLJxvIKUx4bnrEfOmsWLKbDmvG1PCoRkJisMTQka6-QReTrIxdYY3v93f55q)

|

||||

|

||||

|

||||

> 机器学习已应用于多个领域,远远超出大多数人的想象,横跨: 计算机科学、工程技术和统计学等多个学科。

|

||||

|

||||

* 搜索引擎: 根据你的搜索点击,优化你下次的搜索结果,是机器学习来帮助搜索引擎判断哪个结果更适合你(也判断哪个广告更适合你)。

|

||||

* 垃圾邮件: 会自动的过滤垃圾广告邮件到垃圾箱内。

|

||||

* 超市优惠券: 你会发现,你在购买小孩子尿布的时候,售货员会赠送你一张优惠券可以兑换6罐啤酒。

|

||||

* 邮局邮寄: 手写软件自动识别寄送贺卡的地址。

|

||||

* 申请贷款: 通过你最近的金融活动信息进行综合评定,决定你是否合格。

|

||||

|

||||

|

||||

## 机器学习 组成

|

||||

|

||||

### 主要任务

|

||||

|

||||

* 分类(classification): 将实例数据划分到合适的类别中。

|

||||

* 应用实例: 判断网站是否被黑客入侵(二分类 ),手写数字的自动识别(多分类)

|

||||

* 回归(regression): 主要用于预测数值型数据。

|

||||

* 应用实例: 股票价格波动的预测,房屋价格的预测等。

|

||||

|

||||

### 监督学习(supervised learning)

|

||||

|

||||

* 必须确定目标变量的值,以便机器学习算法可以发现特征和目标变量之间的关系。在监督学习中,给定一组数据,我们知道正确的输出结果应该是什么样子,并且知道在输入和输出之间有着一个特定的关系。 (包括: 分类和回归)

|

||||

* 样本集: 训练数据 + 测试数据

|

||||

* 训练样本 = 特征(feature) + 目标变量(label: 分类-离散值/回归-连续值)

|

||||

* 特征通常是训练样本集的列,它们是独立测量得到的。

|

||||

* 目标变量: 目标变量是机器学习预测算法的测试结果。

|

||||

* 在分类算法中目标变量的类型通常是标称型(如: 真与假),而在回归算法中通常是连续型(如: 1~100)。

|

||||

* 监督学习需要注意的问题:

|

||||

* 偏置方差权衡

|

||||

* 功能的复杂性和数量的训练数据

|

||||

* 输入空间的维数

|

||||

* 噪声中的输出值

|

||||

* `知识表示`:

|

||||

* 可以采用规则集的形式【例如: 数学成绩大于90分为优秀】

|

||||

* 可以采用概率分布的形式【例如: 通过统计分布发现,90%的同学数学成绩,在70分以下,那么大于70分定为优秀】

|

||||

* 可以使用训练样本集中的一个实例【例如: 通过样本集合,我们训练出一个模型实例,得出 年轻,数学成绩中高等,谈吐优雅,我们认为是优秀】

|

||||

|

||||

### 非监督学习(unsupervised learning)

|

||||

|

||||

* 在机器学习,无监督学习的问题是,在未加标签的数据中,试图找到隐藏的结构。因为提供给学习者的实例是未标记的,因此没有错误或报酬信号来评估潜在的解决方案。

|

||||

* 无监督学习是密切相关的统计数据密度估计的问题。然而无监督学习还包括寻求,总结和解释数据的主要特点等诸多技术。在无监督学习使用的许多方法是基于用于处理数据的数据挖掘方法。

|

||||

* 数据没有类别信息,也不会给定目标值。

|

||||

* 非监督学习包括的类型:

|

||||

* 聚类: 在无监督学习中,将数据集分成由类似的对象组成多个类的过程称为聚类。

|

||||

* 密度估计: 通过样本分布的紧密程度,来估计与分组的相似性。

|

||||

* 此外,无监督学习还可以减少数据特征的维度,以便我们可以使用二维或三维图形更加直观地展示数据信息。

|

||||

### 强化学习

|

||||

这个算法可以训练程序做出某一决定。程序在某一情况下尝试所有的可能行动,记录不同行动的结果并试着找出最好的一次尝试来做决定。 属于这一类算法的有马尔可夫决策过程。

|

||||

### 训练过程

|

||||

|

||||

|

||||

|

||||

### 算法汇总

|

||||

|

||||

|

||||

|

||||

|

||||

## 机器学习 使用

|

||||

|

||||

> 选择算法需要考虑的两个问题

|

||||

|

||||

1. 算法场景

|

||||

* 预测明天是否下雨,因为可以用历史的天气情况做预测,所以选择监督学习算法

|

||||

* 给一群陌生的人进行分组,但是我们并没有这些人的类别信息,所以选择无监督学习算法、通过他们身高、体重等特征进行处理。

|

||||

2. 需要收集或分析的数据是什么

|

||||

|

||||

> 举例

|

||||

|

||||

|

||||

|

||||

> 机器学习 开发流程

|

||||

|

||||

|

||||

1. 收集数据: 收集样本数据

|

||||

2. 准备数据: 注意数据的格式

|

||||

3. 分析数据: 为了确保数据集中没有垃圾数据;

|

||||

* 如果是算法可以处理的数据格式或可信任的数据源,则可以跳过该步骤;

|

||||

* 另外该步骤需要人工干预,会降低自动化系统的价值。

|

||||

4. 训练算法: [机器学习算法核心]如果使用无监督学习算法,由于不存在目标变量值,则可以跳过该步骤

|

||||

5. 测试算法: [机器学习算法核心]评估算法效果

|

||||

6. 使用算法: 将机器学习算法转为应用程序

|

||||

|

||||

## 机器学习 数学基础

|

||||

* 微积分

|

||||

* 统计学/概率论

|

||||

* 线性代数

|

||||

## 机器学习 工具

|

||||

|

||||

### Python语言

|

||||

|

||||

1. 可执行伪代码

|

||||

2. Python比较流行: 使用广泛、代码范例多、丰富模块库,开发周期短

|

||||

3. Python语言的特色: 清晰简练、易于理解

|

||||

4. Python语言的缺点: 唯一不足的是性能问题

|

||||

5. Python相关的库

|

||||

* 科学函数库: `SciPy`、`NumPy`(底层语言: C和Fortran)

|

||||

* 绘图工具库: `Matplotlib`

|

||||

* 数据分析库 `Pandas`

|

||||

### 数学工具

|

||||

* Matlab

|

||||

## 附: 机器学习专业术语

|

||||

* 模型(model): 计算机层面的认知

|

||||

* 学习算法(learning algorithm),从数据中产生模型的方法

|

||||

* 数据集(data set): 一组记录的合集

|

||||

* 示例(instance): 对于某个对象的描述

|

||||

* 样本(sample): 也叫示例

|

||||

* 属性(attribute): 对象的某方面表现或特征

|

||||

* 特征(feature): 同属性

|

||||

* 属性值(attribute value): 属性上的取值

|

||||

* 属性空间(attribute space): 属性张成的空间

|

||||

* 样本空间/输入空间(samplespace): 同属性空间

|

||||

* 特征向量(feature vector): 在属性空间里每个点对应一个坐标向量,把一个示例称作特征向量

|

||||

* 维数(dimensionality): 描述样本参数的个数(也就是空间是几维的)

|

||||

* 学习(learning)/训练(training): 从数据中学得模型

|

||||

* 训练数据(training data): 训练过程中用到的数据

|

||||

* 训练样本(training sample):训练用到的每个样本

|

||||

* 训练集(training set): 训练样本组成的集合

|

||||

* 假设(hypothesis): 学习模型对应了关于数据的某种潜在规则

|

||||

* 真相(ground-truth):真正存在的潜在规律

|

||||

* 学习器(learner): 模型的另一种叫法,把学习算法在给定数据和参数空间的实例化

|

||||

* 预测(prediction): 判断一个东西的属性

|

||||

* 标记(label): 关于示例的结果信息,比如我是一个“好人”。

|

||||

* 样例(example): 拥有标记的示例

|

||||

* 标记空间/输出空间(label space): 所有标记的集合

|

||||

* 分类(classification): 预测是离散值,比如把人分为好人和坏人之类的学习任务

|

||||

* 回归(regression): 预测值是连续值,比如你的好人程度达到了0.9,0.6之类的

|

||||

* 二分类(binary classification): 只涉及两个类别的分类任务

|

||||

* 正类(positive class): 二分类里的一个

|

||||

* 反类(negative class): 二分类里的另外一个

|

||||

* 多分类(multi-class classification): 涉及多个类别的分类

|

||||

* 测试(testing): 学习到模型之后对样本进行预测的过程

|

||||

* 测试样本(testing sample): 被预测的样本

|

||||

* 聚类(clustering): 把训练集中的对象分为若干组

|

||||

* 簇(cluster): 每一个组叫簇

|

||||

* 监督学习(supervised learning): 典范--分类和回归

|

||||

* 无监督学习(unsupervised learning): 典范--聚类

|

||||

* 未见示例(unseen instance): “新样本“,没训练过的样本

|

||||

* 泛化(generalization)能力: 学得的模型适用于新样本的能力

|

||||

* 分布(distribution): 样本空间的全体样本服从的一种规律

|

||||

* 独立同分布(independent and identically distributed,简称i,i,d.):获得的每个样本都是独立地从这个分布上采样获得的。

|

||||

|

||||

## 机器学习基础补充

|

||||

|

||||

### 数据集的划分

|

||||

|

||||

* 训练集(Training set) —— 学习样本数据集,通过匹配一些参数来建立一个模型,主要用来训练模型。类比考研前做的解题大全。

|

||||

* 验证集(validation set) —— 对学习出来的模型,调整模型的参数,如在神经网络中选择隐藏单元数。验证集还用来确定网络结构或者控制模型复杂程度的参数。类比 考研之前做的模拟考试。

|

||||

* 测试集(Test set) —— 测试训练好的模型的分辨能力。类比 考研。这次真的是一考定终身。

|

||||

|

||||

### 模型拟合程度

|

||||

|

||||

* 欠拟合(Underfitting): 模型没有很好地捕捉到数据特征,不能够很好地拟合数据,对训练样本的一般性质尚未学好。类比,光看书不做题觉得自己什么都会了,上了考场才知道自己啥都不会。

|

||||

* 过拟合(Overfitting): 模型把训练样本学习“太好了”,可能把一些训练样本自身的特性当做了所有潜在样本都有的一般性质,导致泛化能力下降。类比,做课后题全都做对了,超纲题也都认为是考试必考题目,上了考场还是啥都不会。

|

||||

|

||||

通俗来说,欠拟合和过拟合都可以用一句话来说,欠拟合就是: “你太天真了!”,过拟合就是: “你想太多了!”。

|

||||

|

||||

### 常见的模型指标

|

||||

|

||||

* 正确率 —— 提取出的正确信息条数 / 提取出的信息条数

|

||||

* 召回率 —— 提取出的正确信息条数 / 样本中的信息条数

|

||||

* F 值 —— 正确率 * 召回率 * 2 / (正确率 + 召回率)(F值即为正确率和召回率的调和平均值)

|

||||

|

||||

举个例子如下:

|

||||

|

||||

举个例子如下:

|

||||

某池塘有 1400 条鲤鱼,300 只虾,300 只乌龟。现在以捕鲤鱼为目的。撒了一张网,逮住了 700 条鲤鱼,200 只

|

||||

虾, 100 只乌龟。那么这些指标分别如下:

|

||||

正确率 = 700 / (700 + 200 + 100) = 70%

|

||||

召回率 = 700 / 1400 = 50%

|

||||

F 值 = 70% * 50% * 2 / (70% + 50%) = 58.3%

|

||||

|

||||

### 模型

|

||||

|

||||

* 分类问题 —— 说白了就是将一些未知类别的数据分到现在已知的类别中去。比如,根据你的一些信息,判断你是高富帅,还是穷屌丝。评判分类效果好坏的三个指标就是上面介绍的三个指标: 正确率,召回率,F值。

|

||||

* 回归问题 —— 对数值型连续随机变量进行预测和建模的监督学习算法。回归往往会通过计算 误差(Error)来确定模型的精确性。

|

||||

* 聚类问题 —— 聚类是一种无监督学习任务,该算法基于数据的内部结构寻找观察样本的自然族群(即集群)。聚类问题的标准一般基于距离: 簇内距离(Intra-cluster Distance) 和 簇间距离(Inter-cluster Distance) 。簇内距离是越小越好,也就是簇内的元素越相似越好;而簇间距离越大越好,也就是说簇间(不同簇)元素越不相同越好。一般的,衡量聚类问题会给出一个结合簇内距离和簇间距离的公式。

|

||||

|

||||

下面这个图可以比较直观地展示出来:

|

||||

|

||||

|

||||

|

||||

### 特征工程的一些小东西

|

||||

|

||||

* 特征选择 —— 也叫特征子集选择(FSS,Feature Subset Selection)。是指从已有的 M 个特征(Feature)中选择 N 个特征使得系统的特定指标最优化,是从原始特征中选择出一些最有效特征以降低数据集维度的过程,是提高算法性能的一个重要手段,也是模式识别中关键的数据预处理步骤。

|

||||

|

||||

* 特征提取 —— 特征提取是计算机视觉和图像处理中的一个概念。它指的是使用计算机提取图像信息,决定每个图像的点是否属于一个图像特征。特征提取的结果是把图像上的点分为不同的子集,这些子集往往属于孤立的点,连续的曲线或者连续的区域。

|

||||

|

||||

下面给出一个特征工程的图:

|

||||

|

||||

|

||||

|

||||

### 其他

|

||||

|

||||

* Learning rate —— 学习率,通俗地理解,可以理解为步长,步子大了,很容易错过最佳结果。就是本来目标尽在咫尺,可是因为我迈的步子很大,却一下子走过了。步子小了呢,就是同样的距离,我却要走很多很多步,这样导致训练的耗时费力还不讨好。

|

||||

* 一个总结的知识点很棒的链接 : https://zhuanlan.zhihu.com/p/25197792

|

||||

|

||||

* * *

|

||||

|

||||

* **作者: [片刻](http://cwiki.apachecn.org/display/~jiangzhonglian) [1988](http://cwiki.apachecn.org/display/~lihuisong)**

|

||||

* [GitHub地址](https://github.com/apachecn/AiLearning): <https://github.com/apachecn/AiLearning>

|

||||

* **版权声明: 欢迎转载学习 => 请标注信息来源于 [ApacheCN](http://www.apachecn.org/)**

|

||||

@@ -1,246 +1,246 @@

|

||||

# 第 10 章 K-Means(K-均值)聚类算法

|

||||

|

||||

|

||||

|

||||

## 聚类

|

||||

|

||||

聚类,简单来说,就是将一个庞杂数据集中具有相似特征的数据自动归类到一起,称为一个簇,簇内的对象越相似,聚类的效果越好。它是一种无监督的学习(Unsupervised Learning)方法,不需要预先标注好的训练集。聚类与分类最大的区别就是分类的目标事先已知,例如猫狗识别,你在分类之前已经预先知道要将它分为猫、狗两个种类;而在你聚类之前,你对你的目标是未知的,同样以动物为例,对于一个动物集来说,你并不清楚这个数据集内部有多少种类的动物,你能做的只是利用聚类方法将它自动按照特征分为多类,然后人为给出这个聚类结果的定义(即簇识别)。例如,你将一个动物集分为了三簇(类),然后通过观察这三类动物的特征,你为每一个簇起一个名字,如大象、狗、猫等,这就是聚类的基本思想。

|

||||

|

||||

至于“相似”这一概念,是利用距离这个评价标准来衡量的,我们通过计算对象与对象之间的距离远近来判断它们是否属于同一类别,即是否是同一个簇。至于距离如何计算,科学家们提出了许多种距离的计算方法,其中欧式距离是最为简单和常用的,除此之外还有曼哈顿距离和余弦相似性距离等。

|

||||

|

||||

欧式距离,我想大家再熟悉不过了,但为免有一些基础薄弱的同学,在此再说明一下,它的定义为:

|

||||

对于x点坐标为(x1,x2,x3,...,xn)和 y点坐标为(y1,y2,y3,...,yn),两者的欧式距离为:

|

||||

|

||||

$$

|

||||

d(x,y)

|

||||

={\sqrt{

|

||||

(x_{1}-y_{1})^{2}+(x_{2}-y_{2})^{2} + \cdots +(x_{n}-y_{n})^{2}

|

||||

}}

|

||||

={\sqrt{

|

||||

\sum_{ {i=1} }^{n}(x_{i}-y_{i})^{2}

|

||||

}}

|

||||

$$

|

||||

|

||||

在二维平面,它就是我们初中时就学过的两点距离公式

|

||||

|

||||

## K-Means 算法

|

||||

|

||||

K-Means 是发现给定数据集的 K 个簇的聚类算法, 之所以称之为 `K-均值` 是因为它可以发现 K 个不同的簇, 且每个簇的中心采用簇中所含值的均值计算而成.

|

||||

簇个数 K 是用户指定的, 每一个簇通过其质心(centroid), 即簇中所有点的中心来描述.

|

||||

聚类与分类算法的最大区别在于, 分类的目标类别已知, 而聚类的目标类别是未知的.

|

||||

|

||||

**优点**:

|

||||

* 属于无监督学习,无须准备训练集

|

||||

* 原理简单,实现起来较为容易

|

||||

* 结果可解释性较好

|

||||

|

||||

**缺点**:

|

||||

* **需手动设置k值**。 在算法开始预测之前,我们需要手动设置k值,即估计数据大概的类别个数,不合理的k值会使结果缺乏解释性

|

||||

* 可能收敛到局部最小值, 在大规模数据集上收敛较慢

|

||||

* 对于异常点、离群点敏感

|

||||

|

||||

使用数据类型 : 数值型数据

|

||||

|

||||

|

||||

### K-Means 场景

|

||||

kmeans,如前所述,用于数据集内种类属性不明晰,希望能够通过数据挖掘出或自动归类出有相似特点的对象的场景。其商业界的应用场景一般为挖掘出具有相似特点的潜在客户群体以便公司能够重点研究、对症下药。

|

||||

|

||||

例如,在2000年和2004年的美国总统大选中,候选人的得票数比较接近或者说非常接近。任一候选人得到的普选票数的最大百分比为50.7%而最小百分比为47.9% 如果1%的选民将手中的选票投向另外的候选人,那么选举结果就会截然不同。 实际上,如果妥善加以引导与吸引,少部分选民就会转换立场。尽管这类选举者占的比例较低,但当候选人的选票接近时,这些人的立场无疑会对选举结果产生非常大的影响。如何找出这类选民,以及如何在有限的预算下采取措施来吸引他们? 答案就是聚类(Clustering)。

|

||||

|

||||

那么,具体如何实施呢?首先,收集用户的信息,可以同时收集用户满意或不满意的信息,这是因为任何对用户重要的内容都可能影响用户的投票结果。然后,将这些信息输入到某个聚类算法中。接着,对聚类结果中的每一个簇(最好选择最大簇 ), 精心构造能够吸引该簇选民的消息。最后, 开展竞选活动并观察上述做法是否有效。

|

||||

|

||||

另一个例子就是产品部门的市场调研了。为了更好的了解自己的用户,产品部门可以采用聚类的方法得到不同特征的用户群体,然后针对不同的用户群体可以对症下药,为他们提供更加精准有效的服务。

|

||||

|

||||

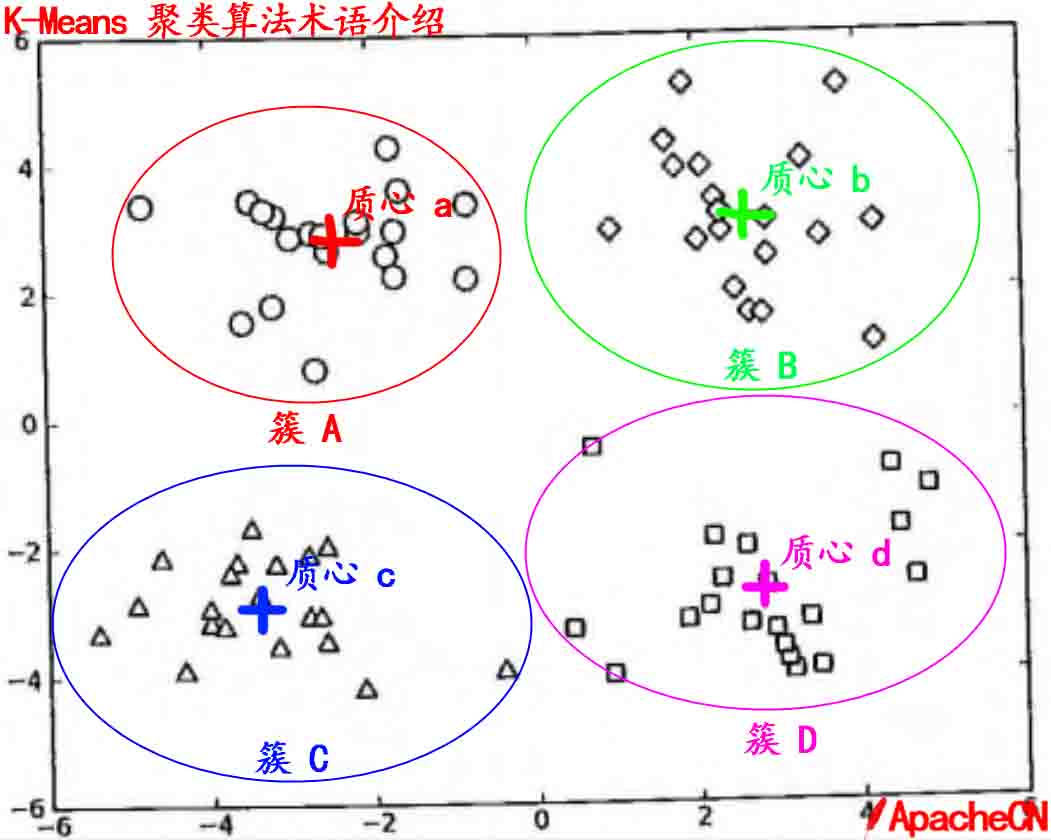

### K-Means 术语

|

||||

|

||||

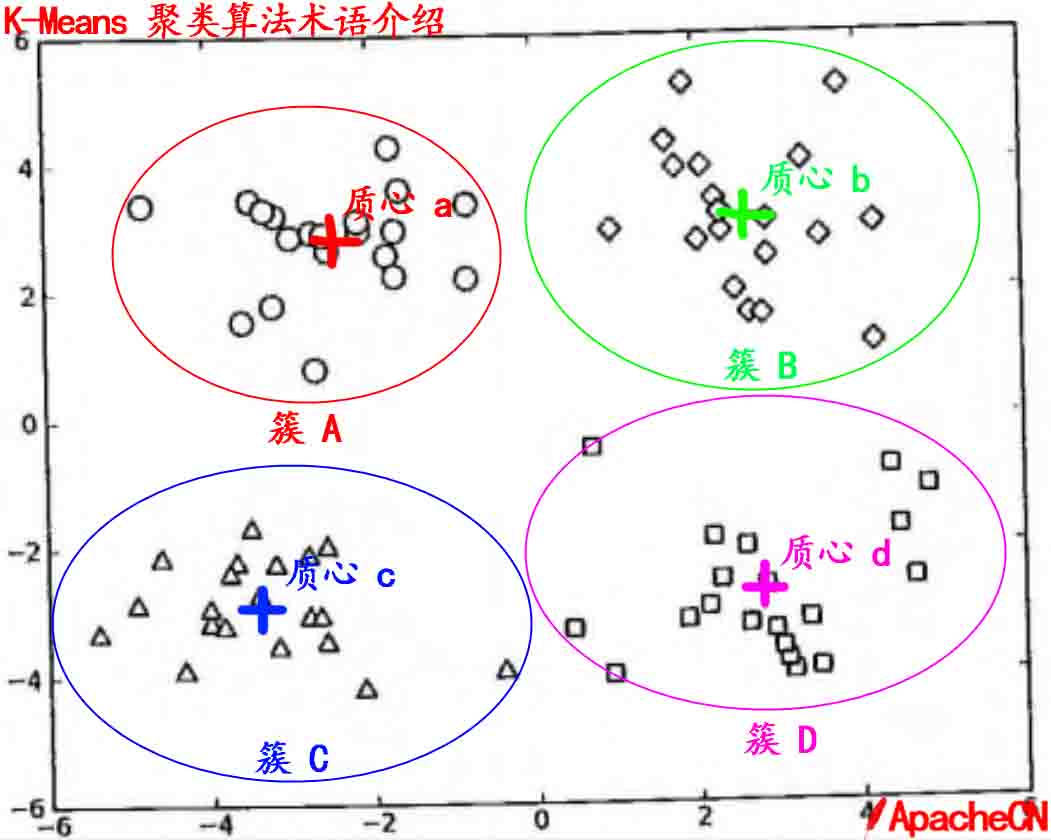

* 簇: 所有数据的点集合,簇中的对象是相似的。

|

||||

* 质心: 簇中所有点的中心(计算所有点的均值而来).

|

||||

* SSE: Sum of Sqared Error(误差平方和), 它被用来评估模型的好坏,SSE 值越小,表示越接近它们的质心. 聚类效果越好。由于对误差取了平方,因此更加注重那些远离中心的点(一般为边界点或离群点)。详情见kmeans的评价标准。

|

||||

|

||||

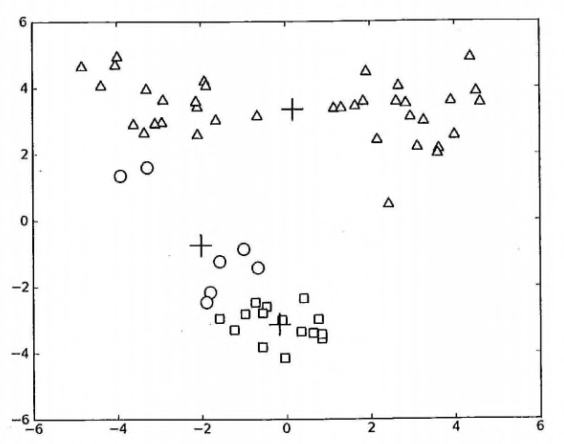

有关 `簇` 和 `质心` 术语更形象的介绍, 请参考下图:

|

||||

|

||||

|

||||

|

||||

### K-Means 工作流程

|

||||

1. 首先, 随机确定 K 个初始点作为质心(**不必是数据中的点**)。

|

||||

2. 然后将数据集中的每个点分配到一个簇中, 具体来讲, 就是为每个点找到距其最近的质心, 并将其分配该质心所对应的簇. 这一步完成之后, 每个簇的质心更新为该簇所有点的平均值.

|

||||

3.重复上述过程直到数据集中的所有点都距离它所对应的质心最近时结束。

|

||||

|

||||

上述过程的 `伪代码` 如下:

|

||||

|

||||

* 创建 k 个点作为起始质心(通常是随机选择)

|

||||

* 当任意一个点的簇分配结果发生改变时(不改变时算法结束)

|

||||

* 对数据集中的每个数据点

|

||||

* 对每个质心

|

||||

* 计算质心与数据点之间的距离

|

||||

* 将数据点分配到距其最近的簇

|

||||

* 对每一个簇, 计算簇中所有点的均值并将均值作为质心

|

||||

|

||||

### K-Means 开发流程

|

||||

|

||||

```

|

||||

收集数据: 使用任意方法

|

||||

准备数据: 需要数值型数据类计算距离, 也可以将标称型数据映射为二值型数据再用于距离计算

|

||||

分析数据: 使用任意方法

|

||||

训练算法: 不适用于无监督学习,即无监督学习不需要训练步骤

|

||||

测试算法: 应用聚类算法、观察结果.可以使用量化的误差指标如误差平方和(后面会介绍)来评价算法的结果.

|

||||

使用算法: 可以用于所希望的任何应用.通常情况下, 簇质心可以代表整个簇的数据来做出决策.

|

||||

```

|

||||

### K-Means 的评价标准

|

||||

k-means算法因为手动选取k值和初始化随机质心的缘故,每一次的结果不会完全一样,而且由于手动选取k值,我们需要知道我们选取的k值是否合理,聚类效果好不好,那么如何来评价某一次的聚类效果呢?也许将它们画在图上直接观察是最好的办法,但现实是,我们的数据不会仅仅只有两个特征,一般来说都有十几个特征,而观察十几维的空间对我们来说是一个无法完成的任务。因此,我们需要一个公式来帮助我们判断聚类的性能,这个公式就是**SSE** (Sum of Squared Error, 误差平方和 ),它其实就是每一个点到其簇内质心的距离的平方值的总和,这个数值对应kmeans函数中**clusterAssment**矩阵的第一列之和。 **SSE**值越小表示数据点越接近于它们的质心,聚类效果也越好。 因为对误差取了平方,因此更加重视那些远离中心的点。一种肯定可以降低**SSE**值的方法是增加簇的个数,但这违背了聚类的目标。聚类的目标是在保持簇数目不变的情况下提高簇的质量。

|

||||

|

||||

### K-Means 聚类算法函数

|

||||

|

||||

#### 从文件加载数据集

|

||||

|

||||

```python

|

||||

# 从文本中构建矩阵,加载文本文件,然后处理

|

||||

def loadDataSet(fileName): # 通用函数,用来解析以 tab 键分隔的 floats(浮点数),例如: 1.658985 4.285136

|

||||

dataMat = []

|

||||

fr = open(fileName)

|

||||

for line in fr.readlines():

|

||||

curLine = line.strip().split('\t')

|

||||

fltLine = map(float,curLine) # 映射所有的元素为 float(浮点数)类型

|

||||

dataMat.append(fltLine)

|

||||

return dataMat

|

||||

```

|

||||

|

||||

#### 计算两个向量的欧氏距离

|

||||

|

||||

```python

|

||||

# 计算两个向量的欧式距离(可根据场景选择其他距离公式)

|

||||

def distEclud(vecA, vecB):

|

||||

return sqrt(sum(power(vecA - vecB, 2))) # la.norm(vecA-vecB)

|

||||

```

|

||||

|

||||

#### 构建一个包含 K 个随机质心的集合

|

||||

|

||||

```python

|

||||

# 为给定数据集构建一个包含 k 个随机质心的集合。随机质心必须要在整个数据集的边界之内,这可以通过找到数据集每一维的最小和最大值来完成。然后生成 0~1.0 之间的随机数并通过取值范围和最小值,以便确保随机点在数据的边界之内。

|

||||

def randCent(dataSet, k):

|

||||

n = shape(dataSet)[1] # 列的数量,即数据的特征个数

|

||||

centroids = mat(zeros((k,n))) # 创建k个质心矩阵

|

||||

for j in range(n): # 创建随机簇质心,并且在每一维的边界内

|

||||

minJ = min(dataSet[:,j]) # 最小值

|

||||

rangeJ = float(max(dataSet[:,j]) - minJ) # 范围 = 最大值 - 最小值

|

||||

centroids[:,j] = mat(minJ + rangeJ * random.rand(k,1)) # 随机生成,mat为numpy函数,需要在最开始写上 from numpy import *

|

||||

return centroids

|

||||

```

|

||||

|

||||

#### K-Means 聚类算法

|

||||

|

||||

```python

|

||||

# k-means 聚类算法

|

||||

# 该算法会创建k个质心,然后将每个点分配到最近的质心,再重新计算质心。

|

||||

# 这个过程重复数次,直到数据点的簇分配结果不再改变位置。

|

||||

# 运行结果(多次运行结果可能会不一样,可以试试,原因为随机质心的影响,但总的结果是对的, 因为数据足够相似,也可能会陷入局部最小值)

|

||||

def kMeans(dataSet, k, distMeas=distEclud, createCent=randCent):

|

||||

m = shape(dataSet)[0] # 行数,即数据个数

|

||||

clusterAssment = mat(zeros((m, 2))) # 创建一个与 dataSet 行数一样,但是有两列的矩阵,用来保存簇分配结果

|

||||

centroids = createCent(dataSet, k) # 创建质心,随机k个质心

|

||||

clusterChanged = True

|

||||

while clusterChanged:

|

||||

clusterChanged = False

|

||||

for i in range(m): # 循环每一个数据点并分配到最近的质心中去

|

||||

minDist = inf; minIndex = -1

|

||||

for j in range(k):

|

||||

distJI = distMeas(centroids[j,:],dataSet[i,:]) # 计算数据点到质心的距离

|

||||

if distJI < minDist: # 如果距离比 minDist(最小距离)还小,更新 minDist(最小距离)和最小质心的 index(索引)

|

||||

minDist = distJI; minIndex = j

|

||||

if clusterAssment[i, 0] != minIndex: # 簇分配结果改变

|

||||

clusterChanged = True # 簇改变

|

||||

clusterAssment[i, :] = minIndex,minDist**2 # 更新簇分配结果为最小质心的 index(索引),minDist(最小距离)的平方

|

||||

print centroids

|

||||

for cent in range(k): # 更新质心

|

||||

ptsInClust = dataSet[nonzero(clusterAssment[:, 0].A==cent)[0]] # 获取该簇中的所有点

|

||||

centroids[cent,:] = mean(ptsInClust, axis=0) # 将质心修改为簇中所有点的平均值,mean 就是求平均值的

|

||||

return centroids, clusterAssment

|

||||

```

|

||||

|

||||

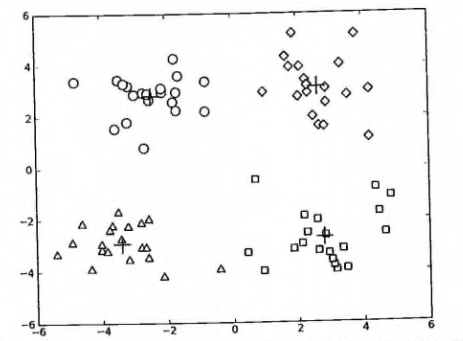

#### 测试函数

|

||||

1. 测试一下以上的基础函数是否可以如预期运行, 请看: <https://github.com/apachecn/AiLearning/blob/master/src/py2.x/ml/10.kmeans/kMeans.py>

|

||||

2. 测试一下 kMeans 函数是否可以如预期运行, 请看: <https://github.com/apachecn/AiLearning/blob/master/src/py2.x/ml/10.kmeans/kMeans.py>

|

||||

|

||||

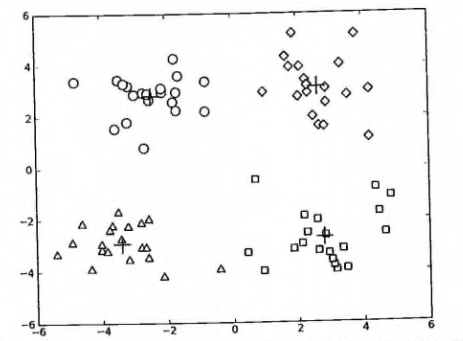

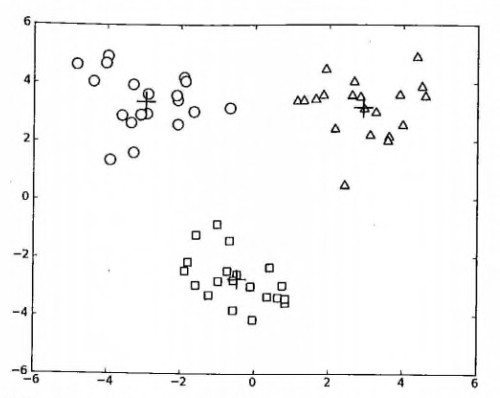

参考运行结果如下:

|

||||

|

||||

|

||||

|

||||

|

||||

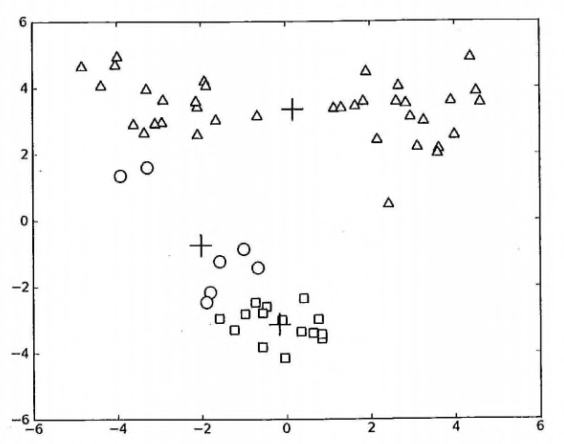

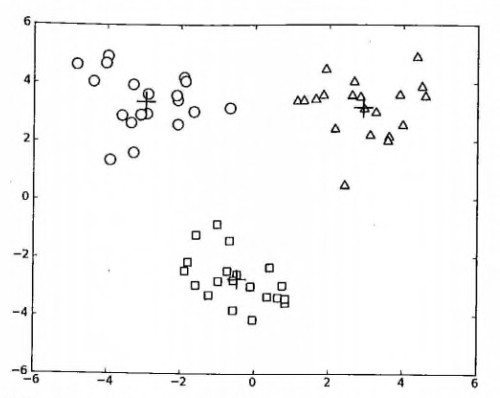

### K-Means 聚类算法的缺陷

|

||||

> 在 kMeans 的函数测试中,可能偶尔会陷入局部最小值(局部最优的结果,但不是全局最优的结果).

|

||||

|

||||

局部最小值的的情况如下:

|

||||

|

||||

出现这个问题有很多原因,可能是k值取的不合适,可能是距离函数不合适,可能是最初随机选取的质心靠的太近,也可能是数据本身分布的问题。

|

||||

|

||||

为了解决这个问题,我们可以对生成的簇进行后处理,一种方法是将具有最大**SSE**值的簇划分成两个簇。具体实现时可以将最大簇包含的点过滤出来并在这些点上运行K-均值算法,令k设为2。

|

||||

|

||||

为了保持簇总数不变,可以将某两个簇进行合并。从上图中很明显就可以看出,应该将上图下部两个出错的簇质心进行合并。那么问题来了,我们可以很容易对二维数据上的聚类进行可视化, 但是如果遇到40维的数据应该如何去做?

|

||||

|

||||

有两种可以量化的办法: 合并最近的质心,或者合并两个使得**SSE**增幅最小的质心。 第一种思路通过计算所有质心之间的距离, 然后合并距离最近的两个点来实现。第二种方法需要合并两个簇然后计算总**SSE**值。必须在所有可能的两个簇上重复上述处理过程,直到找到合并最佳的两个簇为止。

|

||||

|

||||

因为上述后处理过程实在是有些繁琐,所以有更厉害的大佬提出了另一个称之为二分K-均值(bisecting K-Means)的算法.

|

||||

|

||||

### 二分 K-Means 聚类算法

|

||||

该算法首先将所有点作为一个簇,然后将该簇一分为二。

|

||||

之后选择其中一个簇继续进行划分,选择哪一个簇进行划分取决于对其划分时候可以最大程度降低 SSE(平方和误差)的值。

|

||||

上述基于 SSE 的划分过程不断重复,直到得到用户指定的簇数目为止。

|

||||

|

||||

#### 二分 K-Means 聚类算法伪代码

|

||||

* 将所有点看成一个簇

|

||||

* 当簇数目小于 k 时

|

||||

* 对于每一个簇

|

||||

* 计算总误差

|

||||

* 在给定的簇上面进行 KMeans 聚类(k=2)

|

||||

* 计算将该簇一分为二之后的总误差

|

||||

* 选择使得误差最小的那个簇进行划分操作

|

||||

|

||||

另一种做法是选择 SSE 最大的簇进行划分,直到簇数目达到用户指定的数目位置。

|

||||

接下来主要介绍该做法的python2代码实现

|

||||

|

||||

#### 二分 K-Means 聚类算法代码

|

||||

|

||||

```python

|

||||

# 二分 KMeans 聚类算法, 基于 kMeans 基础之上的优化,以避免陷入局部最小值

|

||||

def biKMeans(dataSet, k, distMeas=distEclud):

|

||||

m = shape(dataSet)[0]

|

||||

clusterAssment = mat(zeros((m,2))) # 保存每个数据点的簇分配结果和平方误差

|

||||

centroid0 = mean(dataSet, axis=0).tolist()[0] # 质心初始化为所有数据点的均值

|

||||

centList =[centroid0] # 初始化只有 1 个质心的 list

|

||||

for j in range(m): # 计算所有数据点到初始质心的距离平方误差

|

||||

clusterAssment[j,1] = distMeas(mat(centroid0), dataSet[j,:])**2

|

||||

while (len(centList) < k): # 当质心数量小于 k 时

|

||||

lowestSSE = inf

|

||||

for i in range(len(centList)): # 对每一个质心

|

||||

ptsInCurrCluster = dataSet[nonzero(clusterAssment[:,0].A==i)[0],:] # 获取当前簇 i 下的所有数据点

|

||||

centroidMat, splitClustAss = kMeans(ptsInCurrCluster, 2, distMeas) # 将当前簇 i 进行二分 kMeans 处理

|

||||

sseSplit = sum(splitClustAss[:,1]) # 将二分 kMeans 结果中的平方和的距离进行求和

|

||||

sseNotSplit = sum(clusterAssment[nonzero(clusterAssment[:,0].A!=i)[0],1]) # 将未参与二分 kMeans 分配结果中的平方和的距离进行求和

|

||||

print "sseSplit, and notSplit: ",sseSplit,sseNotSplit

|

||||

if (sseSplit + sseNotSplit) < lowestSSE: # 总的(未拆分和已拆分)误差和越小,越相似,效果越优化,划分的结果更好(注意: 这里的理解很重要,不明白的地方可以和我们一起讨论)

|

||||

bestCentToSplit = i

|

||||

bestNewCents = centroidMat

|

||||

bestClustAss = splitClustAss.copy()

|

||||

lowestSSE = sseSplit + sseNotSplit

|

||||

# 找出最好的簇分配结果

|

||||

bestClustAss[nonzero(bestClustAss[:,0].A == 1)[0],0] = len(centList) # 调用二分 kMeans 的结果,默认簇是 0,1. 当然也可以改成其它的数字

|

||||

bestClustAss[nonzero(bestClustAss[:,0].A == 0)[0],0] = bestCentToSplit # 更新为最佳质心

|

||||

print 'the bestCentToSplit is: ',bestCentToSplit

|

||||

print 'the len of bestClustAss is: ', len(bestClustAss)

|

||||

# 更新质心列表

|

||||

centList[bestCentToSplit] = bestNewCents[0,:].tolist()[0] # 更新原质心 list 中的第 i 个质心为使用二分 kMeans 后 bestNewCents 的第一个质心

|

||||

centList.append(bestNewCents[1,:].tolist()[0]) # 添加 bestNewCents 的第二个质心

|

||||

clusterAssment[nonzero(clusterAssment[:,0].A == bestCentToSplit)[0],:]= bestClustAss # 重新分配最好簇下的数据(质心)以及SSE

|

||||

return mat(centList), clusterAssment

|

||||

```

|

||||

|

||||

#### 测试二分 KMeans 聚类算法

|

||||

* 测试一下二分 KMeans 聚类算法,请看: <https://github.com/apachecn/AiLearning/blob/master/src/py2.x/ml/10.kmeans/kMeans.py>

|

||||

|

||||

上述函数可以运行多次,聚类会收敛到全局最小值,而原始的 kMeans() 函数偶尔会陷入局部最小值。

|

||||

运行参考结果如下:

|

||||

|

||||

|

||||

* **作者: [那伊抹微笑](http://cwiki.apachecn.org/display/~xuxin), [清都江水郎](http://cwiki.apachecn.org/display/~xuzhaoqing)**

|

||||

* [GitHub地址](https://github.com/apachecn/AiLearning): <https://github.com/apachecn/AiLearning>

|

||||

# 第 10 章 K-Means(K-均值)聚类算法

|

||||

|

||||

|

||||

|

||||

## 聚类

|

||||

|

||||

聚类,简单来说,就是将一个庞杂数据集中具有相似特征的数据自动归类到一起,称为一个簇,簇内的对象越相似,聚类的效果越好。它是一种无监督的学习(Unsupervised Learning)方法,不需要预先标注好的训练集。聚类与分类最大的区别就是分类的目标事先已知,例如猫狗识别,你在分类之前已经预先知道要将它分为猫、狗两个种类;而在你聚类之前,你对你的目标是未知的,同样以动物为例,对于一个动物集来说,你并不清楚这个数据集内部有多少种类的动物,你能做的只是利用聚类方法将它自动按照特征分为多类,然后人为给出这个聚类结果的定义(即簇识别)。例如,你将一个动物集分为了三簇(类),然后通过观察这三类动物的特征,你为每一个簇起一个名字,如大象、狗、猫等,这就是聚类的基本思想。

|

||||

|

||||

至于“相似”这一概念,是利用距离这个评价标准来衡量的,我们通过计算对象与对象之间的距离远近来判断它们是否属于同一类别,即是否是同一个簇。至于距离如何计算,科学家们提出了许多种距离的计算方法,其中欧式距离是最为简单和常用的,除此之外还有曼哈顿距离和余弦相似性距离等。

|

||||

|

||||

欧式距离,我想大家再熟悉不过了,但为免有一些基础薄弱的同学,在此再说明一下,它的定义为:

|

||||

对于x点坐标为(x1,x2,x3,...,xn)和 y点坐标为(y1,y2,y3,...,yn),两者的欧式距离为:

|

||||

|

||||

$$

|

||||

d(x,y)

|

||||

={\sqrt{

|

||||

(x_{1}-y_{1})^{2}+(x_{2}-y_{2})^{2} + \cdots +(x_{n}-y_{n})^{2}

|

||||

}}

|

||||

={\sqrt{

|

||||

\sum_{ {i=1} }^{n}(x_{i}-y_{i})^{2}

|

||||

}}

|

||||

$$

|

||||

|

||||

在二维平面,它就是我们初中时就学过的两点距离公式

|

||||

|

||||

## K-Means 算法

|

||||

|

||||

K-Means 是发现给定数据集的 K 个簇的聚类算法, 之所以称之为 `K-均值` 是因为它可以发现 K 个不同的簇, 且每个簇的中心采用簇中所含值的均值计算而成.

|

||||

簇个数 K 是用户指定的, 每一个簇通过其质心(centroid), 即簇中所有点的中心来描述.

|

||||

聚类与分类算法的最大区别在于, 分类的目标类别已知, 而聚类的目标类别是未知的.

|

||||

|

||||

**优点**:

|

||||

* 属于无监督学习,无须准备训练集

|

||||

* 原理简单,实现起来较为容易

|

||||

* 结果可解释性较好

|

||||

|

||||

**缺点**:

|

||||

* **需手动设置k值**。 在算法开始预测之前,我们需要手动设置k值,即估计数据大概的类别个数,不合理的k值会使结果缺乏解释性

|

||||

* 可能收敛到局部最小值, 在大规模数据集上收敛较慢

|

||||

* 对于异常点、离群点敏感

|

||||

|

||||

使用数据类型 : 数值型数据

|

||||

|

||||

|

||||

### K-Means 场景

|

||||

kmeans,如前所述,用于数据集内种类属性不明晰,希望能够通过数据挖掘出或自动归类出有相似特点的对象的场景。其商业界的应用场景一般为挖掘出具有相似特点的潜在客户群体以便公司能够重点研究、对症下药。

|

||||

|

||||

例如,在2000年和2004年的美国总统大选中,候选人的得票数比较接近或者说非常接近。任一候选人得到的普选票数的最大百分比为50.7%而最小百分比为47.9% 如果1%的选民将手中的选票投向另外的候选人,那么选举结果就会截然不同。 实际上,如果妥善加以引导与吸引,少部分选民就会转换立场。尽管这类选举者占的比例较低,但当候选人的选票接近时,这些人的立场无疑会对选举结果产生非常大的影响。如何找出这类选民,以及如何在有限的预算下采取措施来吸引他们? 答案就是聚类(Clustering)。

|

||||

|

||||

那么,具体如何实施呢?首先,收集用户的信息,可以同时收集用户满意或不满意的信息,这是因为任何对用户重要的内容都可能影响用户的投票结果。然后,将这些信息输入到某个聚类算法中。接着,对聚类结果中的每一个簇(最好选择最大簇 ), 精心构造能够吸引该簇选民的消息。最后, 开展竞选活动并观察上述做法是否有效。

|

||||

|

||||

另一个例子就是产品部门的市场调研了。为了更好的了解自己的用户,产品部门可以采用聚类的方法得到不同特征的用户群体,然后针对不同的用户群体可以对症下药,为他们提供更加精准有效的服务。

|

||||

|

||||

### K-Means 术语

|

||||

|

||||

* 簇: 所有数据的点集合,簇中的对象是相似的。

|

||||

* 质心: 簇中所有点的中心(计算所有点的均值而来).

|

||||

* SSE: Sum of Sqared Error(误差平方和), 它被用来评估模型的好坏,SSE 值越小,表示越接近它们的质心. 聚类效果越好。由于对误差取了平方,因此更加注重那些远离中心的点(一般为边界点或离群点)。详情见kmeans的评价标准。

|

||||

|

||||

有关 `簇` 和 `质心` 术语更形象的介绍, 请参考下图:

|

||||

|

||||

|

||||

|

||||

### K-Means 工作流程

|

||||

1. 首先, 随机确定 K 个初始点作为质心(**不必是数据中的点**)。

|

||||

2. 然后将数据集中的每个点分配到一个簇中, 具体来讲, 就是为每个点找到距其最近的质心, 并将其分配该质心所对应的簇. 这一步完成之后, 每个簇的质心更新为该簇所有点的平均值.

|

||||

3.重复上述过程直到数据集中的所有点都距离它所对应的质心最近时结束。

|

||||

|

||||

上述过程的 `伪代码` 如下:

|

||||

|

||||

* 创建 k 个点作为起始质心(通常是随机选择)

|

||||

* 当任意一个点的簇分配结果发生改变时(不改变时算法结束)

|

||||

* 对数据集中的每个数据点

|

||||

* 对每个质心

|

||||

* 计算质心与数据点之间的距离

|

||||

* 将数据点分配到距其最近的簇

|

||||

* 对每一个簇, 计算簇中所有点的均值并将均值作为质心

|

||||

|

||||

### K-Means 开发流程

|

||||

|

||||

```

|

||||

收集数据: 使用任意方法

|

||||

准备数据: 需要数值型数据类计算距离, 也可以将标称型数据映射为二值型数据再用于距离计算

|

||||

分析数据: 使用任意方法

|

||||

训练算法: 不适用于无监督学习,即无监督学习不需要训练步骤

|

||||

测试算法: 应用聚类算法、观察结果.可以使用量化的误差指标如误差平方和(后面会介绍)来评价算法的结果.

|

||||

使用算法: 可以用于所希望的任何应用.通常情况下, 簇质心可以代表整个簇的数据来做出决策.

|

||||

```

|

||||

### K-Means 的评价标准

|

||||

k-means算法因为手动选取k值和初始化随机质心的缘故,每一次的结果不会完全一样,而且由于手动选取k值,我们需要知道我们选取的k值是否合理,聚类效果好不好,那么如何来评价某一次的聚类效果呢?也许将它们画在图上直接观察是最好的办法,但现实是,我们的数据不会仅仅只有两个特征,一般来说都有十几个特征,而观察十几维的空间对我们来说是一个无法完成的任务。因此,我们需要一个公式来帮助我们判断聚类的性能,这个公式就是**SSE** (Sum of Squared Error, 误差平方和 ),它其实就是每一个点到其簇内质心的距离的平方值的总和,这个数值对应kmeans函数中**clusterAssment**矩阵的第一列之和。 **SSE**值越小表示数据点越接近于它们的质心,聚类效果也越好。 因为对误差取了平方,因此更加重视那些远离中心的点。一种肯定可以降低**SSE**值的方法是增加簇的个数,但这违背了聚类的目标。聚类的目标是在保持簇数目不变的情况下提高簇的质量。

|

||||

|

||||

### K-Means 聚类算法函数

|

||||

|

||||

#### 从文件加载数据集

|

||||

|

||||

```python

|

||||

# 从文本中构建矩阵,加载文本文件,然后处理

|

||||

def loadDataSet(fileName): # 通用函数,用来解析以 tab 键分隔的 floats(浮点数),例如: 1.658985 4.285136

|

||||

dataMat = []

|

||||

fr = open(fileName)

|

||||

for line in fr.readlines():

|

||||

curLine = line.strip().split('\t')

|

||||

fltLine = map(float,curLine) # 映射所有的元素为 float(浮点数)类型

|

||||

dataMat.append(fltLine)

|

||||

return dataMat

|

||||

```

|

||||

|

||||

#### 计算两个向量的欧氏距离

|

||||

|

||||

```python

|

||||

# 计算两个向量的欧式距离(可根据场景选择其他距离公式)

|

||||

def distEclud(vecA, vecB):

|

||||

return sqrt(sum(power(vecA - vecB, 2))) # la.norm(vecA-vecB)

|

||||

```

|

||||

|

||||

#### 构建一个包含 K 个随机质心的集合

|

||||

|

||||

```python

|

||||

# 为给定数据集构建一个包含 k 个随机质心的集合。随机质心必须要在整个数据集的边界之内,这可以通过找到数据集每一维的最小和最大值来完成。然后生成 0~1.0 之间的随机数并通过取值范围和最小值,以便确保随机点在数据的边界之内。

|

||||

def randCent(dataSet, k):

|

||||

n = shape(dataSet)[1] # 列的数量,即数据的特征个数

|

||||

centroids = mat(zeros((k,n))) # 创建k个质心矩阵

|

||||

for j in range(n): # 创建随机簇质心,并且在每一维的边界内

|

||||

minJ = min(dataSet[:,j]) # 最小值

|

||||

rangeJ = float(max(dataSet[:,j]) - minJ) # 范围 = 最大值 - 最小值

|

||||

centroids[:,j] = mat(minJ + rangeJ * random.rand(k,1)) # 随机生成,mat为numpy函数,需要在最开始写上 from numpy import *

|

||||

return centroids

|

||||

```

|

||||

|

||||

#### K-Means 聚类算法

|

||||

|

||||

```python

|

||||

# k-means 聚类算法

|

||||

# 该算法会创建k个质心,然后将每个点分配到最近的质心,再重新计算质心。

|

||||

# 这个过程重复数次,直到数据点的簇分配结果不再改变位置。

|

||||

# 运行结果(多次运行结果可能会不一样,可以试试,原因为随机质心的影响,但总的结果是对的, 因为数据足够相似,也可能会陷入局部最小值)

|

||||

def kMeans(dataSet, k, distMeas=distEclud, createCent=randCent):

|

||||

m = shape(dataSet)[0] # 行数,即数据个数

|

||||

clusterAssment = mat(zeros((m, 2))) # 创建一个与 dataSet 行数一样,但是有两列的矩阵,用来保存簇分配结果

|

||||

centroids = createCent(dataSet, k) # 创建质心,随机k个质心

|

||||

clusterChanged = True

|

||||

while clusterChanged:

|

||||

clusterChanged = False

|

||||

for i in range(m): # 循环每一个数据点并分配到最近的质心中去

|

||||

minDist = inf; minIndex = -1

|

||||

for j in range(k):

|

||||

distJI = distMeas(centroids[j,:],dataSet[i,:]) # 计算数据点到质心的距离

|

||||

if distJI < minDist: # 如果距离比 minDist(最小距离)还小,更新 minDist(最小距离)和最小质心的 index(索引)

|

||||

minDist = distJI; minIndex = j

|

||||

if clusterAssment[i, 0] != minIndex: # 簇分配结果改变

|

||||

clusterChanged = True # 簇改变

|

||||

clusterAssment[i, :] = minIndex,minDist**2 # 更新簇分配结果为最小质心的 index(索引),minDist(最小距离)的平方

|

||||

print centroids

|

||||

for cent in range(k): # 更新质心

|

||||

ptsInClust = dataSet[nonzero(clusterAssment[:, 0].A==cent)[0]] # 获取该簇中的所有点

|

||||

centroids[cent,:] = mean(ptsInClust, axis=0) # 将质心修改为簇中所有点的平均值,mean 就是求平均值的

|

||||

return centroids, clusterAssment

|

||||

```

|

||||

|

||||

#### 测试函数

|

||||

1. 测试一下以上的基础函数是否可以如预期运行, 请看: <https://github.com/apachecn/AiLearning/blob/master/src/py2.x/ml/10.kmeans/kMeans.py>

|

||||

2. 测试一下 kMeans 函数是否可以如预期运行, 请看: <https://github.com/apachecn/AiLearning/blob/master/src/py2.x/ml/10.kmeans/kMeans.py>

|

||||

|

||||

参考运行结果如下:

|

||||

|

||||

|

||||

|

||||

|

||||

### K-Means 聚类算法的缺陷

|

||||

> 在 kMeans 的函数测试中,可能偶尔会陷入局部最小值(局部最优的结果,但不是全局最优的结果).

|

||||

|

||||

局部最小值的的情况如下:

|

||||

|

||||

出现这个问题有很多原因,可能是k值取的不合适,可能是距离函数不合适,可能是最初随机选取的质心靠的太近,也可能是数据本身分布的问题。

|

||||

|

||||

为了解决这个问题,我们可以对生成的簇进行后处理,一种方法是将具有最大**SSE**值的簇划分成两个簇。具体实现时可以将最大簇包含的点过滤出来并在这些点上运行K-均值算法,令k设为2。

|

||||

|

||||

为了保持簇总数不变,可以将某两个簇进行合并。从上图中很明显就可以看出,应该将上图下部两个出错的簇质心进行合并。那么问题来了,我们可以很容易对二维数据上的聚类进行可视化, 但是如果遇到40维的数据应该如何去做?

|

||||

|

||||

有两种可以量化的办法: 合并最近的质心,或者合并两个使得**SSE**增幅最小的质心。 第一种思路通过计算所有质心之间的距离, 然后合并距离最近的两个点来实现。第二种方法需要合并两个簇然后计算总**SSE**值。必须在所有可能的两个簇上重复上述处理过程,直到找到合并最佳的两个簇为止。

|

||||

|

||||

因为上述后处理过程实在是有些繁琐,所以有更厉害的大佬提出了另一个称之为二分K-均值(bisecting K-Means)的算法.

|

||||

|

||||

### 二分 K-Means 聚类算法

|

||||

该算法首先将所有点作为一个簇,然后将该簇一分为二。

|

||||

之后选择其中一个簇继续进行划分,选择哪一个簇进行划分取决于对其划分时候可以最大程度降低 SSE(平方和误差)的值。

|

||||

上述基于 SSE 的划分过程不断重复,直到得到用户指定的簇数目为止。

|

||||

|

||||

#### 二分 K-Means 聚类算法伪代码

|

||||

* 将所有点看成一个簇

|

||||

* 当簇数目小于 k 时

|

||||

* 对于每一个簇

|

||||

* 计算总误差

|

||||

* 在给定的簇上面进行 KMeans 聚类(k=2)

|

||||

* 计算将该簇一分为二之后的总误差

|

||||

* 选择使得误差最小的那个簇进行划分操作

|

||||

|

||||

另一种做法是选择 SSE 最大的簇进行划分,直到簇数目达到用户指定的数目位置。

|

||||

接下来主要介绍该做法的python2代码实现

|

||||

|

||||

#### 二分 K-Means 聚类算法代码

|

||||

|

||||

```python

|

||||

# 二分 KMeans 聚类算法, 基于 kMeans 基础之上的优化,以避免陷入局部最小值

|

||||

def biKMeans(dataSet, k, distMeas=distEclud):

|

||||

m = shape(dataSet)[0]

|

||||

clusterAssment = mat(zeros((m,2))) # 保存每个数据点的簇分配结果和平方误差

|

||||

centroid0 = mean(dataSet, axis=0).tolist()[0] # 质心初始化为所有数据点的均值

|

||||

centList =[centroid0] # 初始化只有 1 个质心的 list

|

||||

for j in range(m): # 计算所有数据点到初始质心的距离平方误差

|

||||

clusterAssment[j,1] = distMeas(mat(centroid0), dataSet[j,:])**2

|

||||

while (len(centList) < k): # 当质心数量小于 k 时

|

||||

lowestSSE = inf

|

||||

for i in range(len(centList)): # 对每一个质心

|

||||

ptsInCurrCluster = dataSet[nonzero(clusterAssment[:,0].A==i)[0],:] # 获取当前簇 i 下的所有数据点

|

||||

centroidMat, splitClustAss = kMeans(ptsInCurrCluster, 2, distMeas) # 将当前簇 i 进行二分 kMeans 处理

|

||||

sseSplit = sum(splitClustAss[:,1]) # 将二分 kMeans 结果中的平方和的距离进行求和

|

||||

sseNotSplit = sum(clusterAssment[nonzero(clusterAssment[:,0].A!=i)[0],1]) # 将未参与二分 kMeans 分配结果中的平方和的距离进行求和

|

||||

print "sseSplit, and notSplit: ",sseSplit,sseNotSplit

|

||||

if (sseSplit + sseNotSplit) < lowestSSE: # 总的(未拆分和已拆分)误差和越小,越相似,效果越优化,划分的结果更好(注意: 这里的理解很重要,不明白的地方可以和我们一起讨论)

|

||||

bestCentToSplit = i

|

||||

bestNewCents = centroidMat

|

||||

bestClustAss = splitClustAss.copy()

|

||||

lowestSSE = sseSplit + sseNotSplit

|

||||

# 找出最好的簇分配结果

|

||||

bestClustAss[nonzero(bestClustAss[:,0].A == 1)[0],0] = len(centList) # 调用二分 kMeans 的结果,默认簇是 0,1. 当然也可以改成其它的数字

|

||||

bestClustAss[nonzero(bestClustAss[:,0].A == 0)[0],0] = bestCentToSplit # 更新为最佳质心

|

||||

print 'the bestCentToSplit is: ',bestCentToSplit

|

||||

print 'the len of bestClustAss is: ', len(bestClustAss)

|

||||

# 更新质心列表

|

||||

centList[bestCentToSplit] = bestNewCents[0,:].tolist()[0] # 更新原质心 list 中的第 i 个质心为使用二分 kMeans 后 bestNewCents 的第一个质心

|

||||

centList.append(bestNewCents[1,:].tolist()[0]) # 添加 bestNewCents 的第二个质心

|

||||

clusterAssment[nonzero(clusterAssment[:,0].A == bestCentToSplit)[0],:]= bestClustAss # 重新分配最好簇下的数据(质心)以及SSE

|

||||

return mat(centList), clusterAssment

|

||||

```

|

||||

|

||||

#### 测试二分 KMeans 聚类算法

|

||||

* 测试一下二分 KMeans 聚类算法,请看: <https://github.com/apachecn/AiLearning/blob/master/src/py2.x/ml/10.kmeans/kMeans.py>

|

||||

|

||||

上述函数可以运行多次,聚类会收敛到全局最小值,而原始的 kMeans() 函数偶尔会陷入局部最小值。

|

||||

运行参考结果如下:

|

||||

|

||||

|

||||

* **作者: [那伊抹微笑](http://cwiki.apachecn.org/display/~xuxin), [清都江水郎](http://cwiki.apachecn.org/display/~xuzhaoqing)**

|

||||

* [GitHub地址](https://github.com/apachecn/AiLearning): <https://github.com/apachecn/AiLearning>

|

||||

* **版权声明: 欢迎转载学习 => 请标注信息来源于 [ApacheCN](http://www.apachecn.org/)**

|

||||

@@ -1,396 +1,396 @@

|

||||

|

||||

# 第 11 章 使用 Apriori 算法进行关联分析

|

||||

|

||||

|

||||

|

||||

## 关联分析

|

||||

关联分析是一种在大规模数据集中寻找有趣关系的任务。

|

||||

这些关系可以有两种形式:

|

||||

* 频繁项集(frequent item sets): 经常出现在一块的物品的集合。

|

||||

* 关联规则(associational rules): 暗示两种物品之间可能存在很强的关系。

|

||||

|

||||

## 相关术语

|

||||

* 关联分析(关联规则学习): 从大规模数据集中寻找物品间的隐含关系被称作 `关联分析(associati analysis)` 或者 `关联规则学习(association rule learning)` 。

|

||||

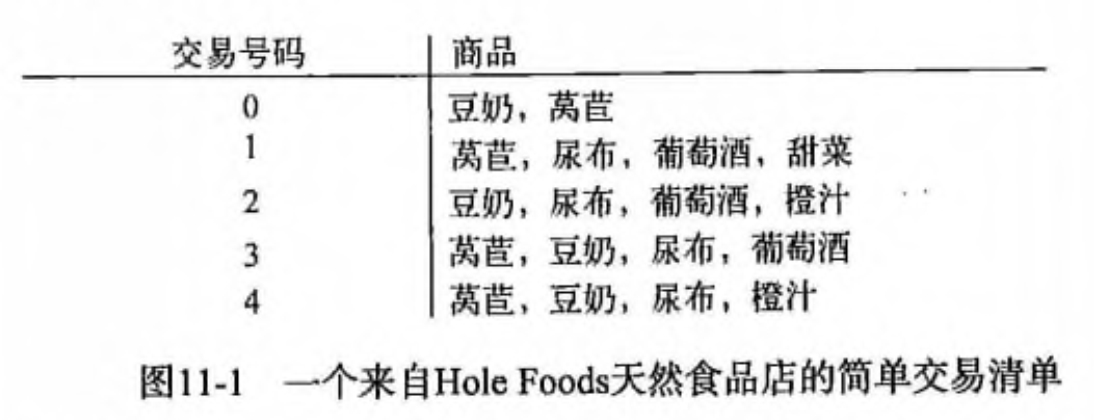

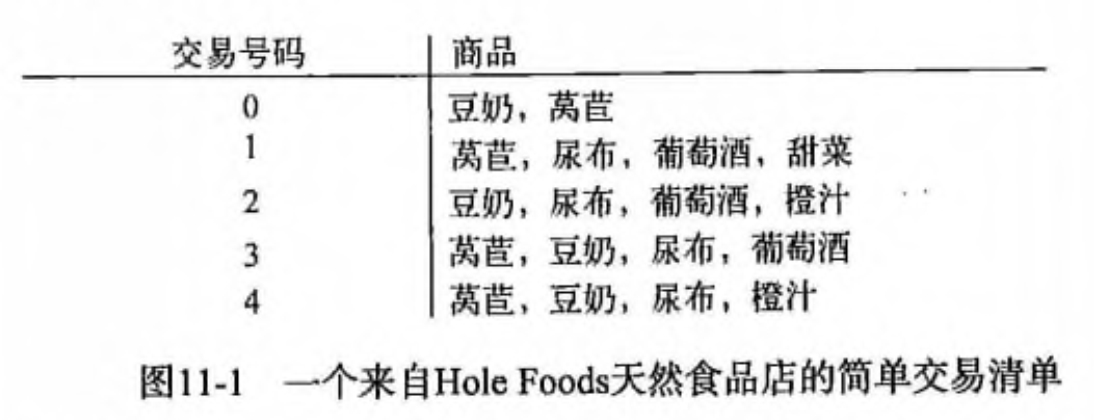

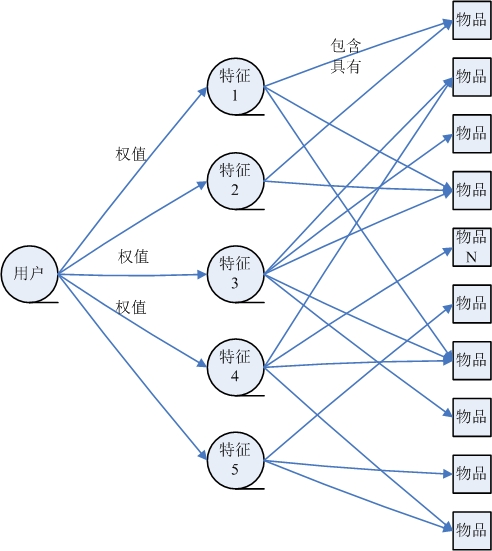

下面是用一个 `杂货店` 例子来说明这两个概念,如下图所示:

|

||||

|

||||

|

||||

* 频繁项集: {葡萄酒, 尿布, 豆奶} 就是一个频繁项集的例子。

|

||||

* 关联规则: 尿布 -> 葡萄酒 就是一个关联规则。这意味着如果顾客买了尿布,那么他很可能会买葡萄酒。

|

||||

|

||||

那么 `频繁` 的定义是什么呢?怎么样才算频繁呢?

|

||||

度量它们的方法有很多种,这里我们来简单的介绍下支持度和可信度。

|

||||

* 支持度: 数据集中包含该项集的记录所占的比例。例如上图中,{豆奶} 的支持度为 4/5。{豆奶, 尿布} 的支持度为 3/5。

|

||||

* 可信度: 针对一条诸如 {尿布} -> {葡萄酒} 这样具体的关联规则来定义的。这条规则的 `可信度` 被定义为 `支持度({尿布, 葡萄酒})/支持度({尿布})`,从图中可以看出 支持度({尿布, 葡萄酒}) = 3/5,支持度({尿布}) = 4/5,所以 {尿布} -> {葡萄酒} 的可信度 = 3/5 / 4/5 = 3/4 = 0.75。

|

||||

|

||||

`支持度` 和 `可信度` 是用来量化 `关联分析` 是否成功的一个方法。

|

||||

假设想找到支持度大于 0.8 的所有项集,应该如何去做呢?

|

||||

一个办法是生成一个物品所有可能组合的清单,然后对每一种组合统计它出现的频繁程度,但是当物品成千上万时,上述做法就非常非常慢了。

|

||||

我们需要详细分析下这种情况并讨论下 Apriori 原理,该原理会减少关联规则学习时所需的计算量。

|

||||

|

||||

## Apriori 原理

|

||||

|

||||

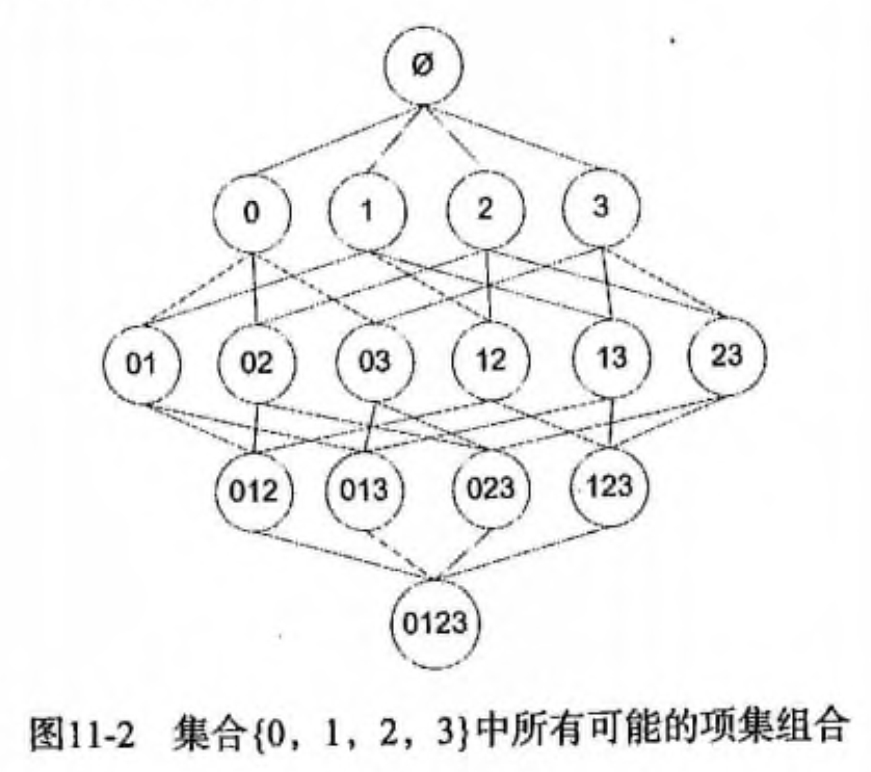

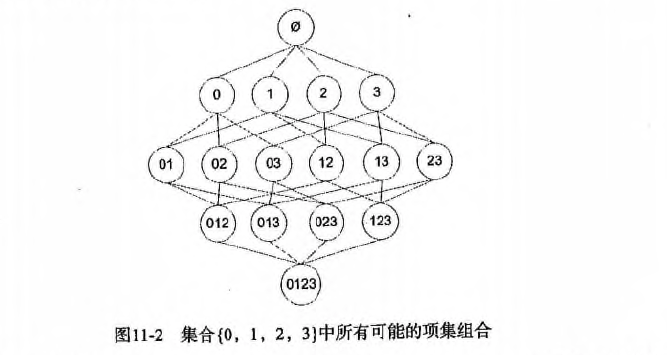

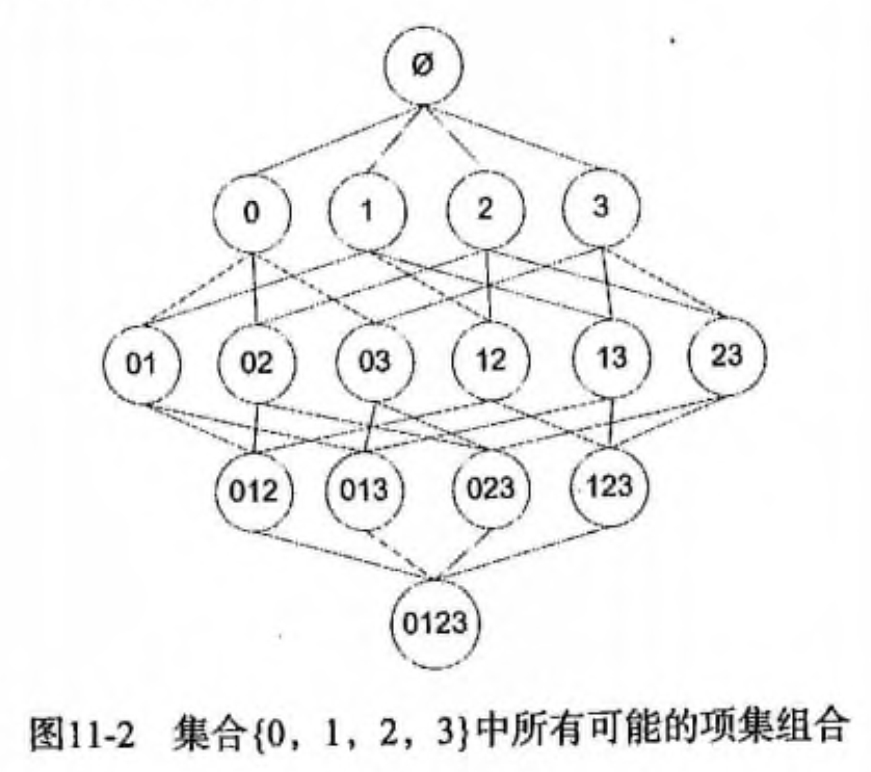

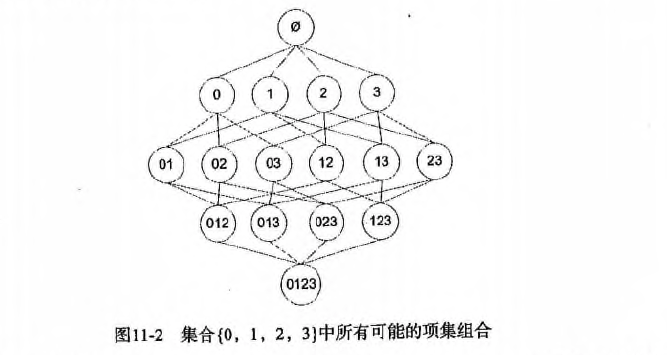

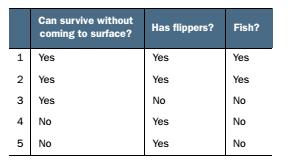

假设我们一共有 4 个商品: 商品0, 商品1, 商品2, 商品3。

|

||||

所有可能的情况如下:

|

||||

|

||||

如果我们计算所有组合的支持度,也需要计算 15 次。即 2^N - 1 = 2^4 - 1 = 15。

|

||||

随着物品的增加,计算的次数呈指数的形式增长 ...

|

||||

为了降低计算次数和时间,研究人员发现了一种所谓的 Apriori 原理,即某个项集是频繁的,那么它的所有子集也是频繁的。

|

||||

例如,如果 {0, 1} 是频繁的,那么 {0}, {1} 也是频繁的。

|

||||

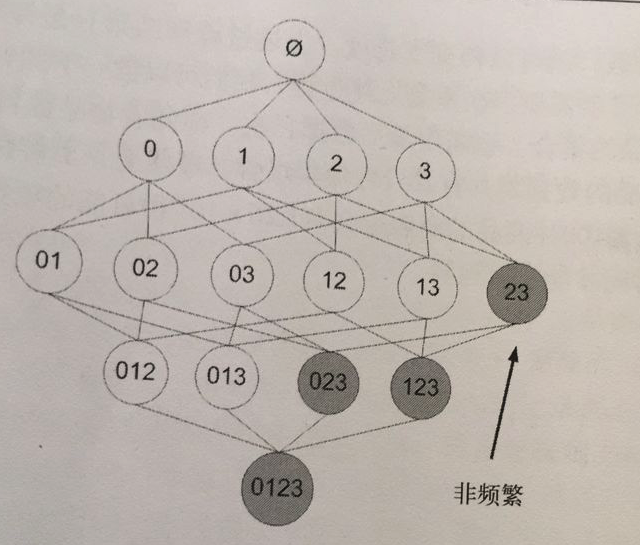

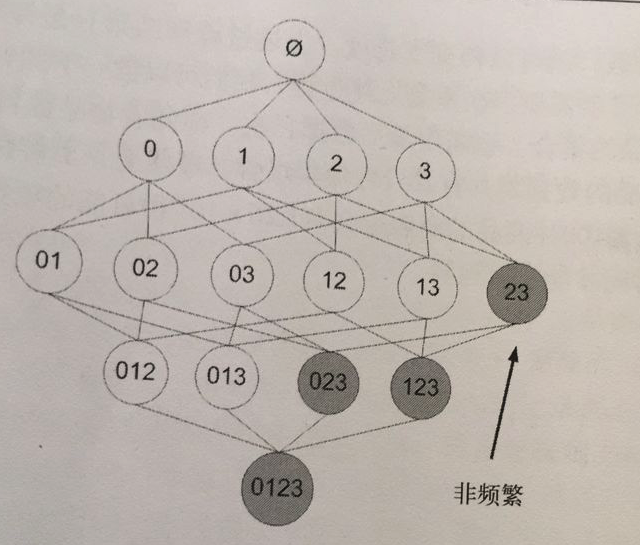

该原理直观上没有什么帮助,但是如果反过来看就有用了,也就是说如果一个项集是 `非频繁项集`,那么它的所有超集也是非频繁项集,如下图所示:

|

||||

|

||||

|

||||

|

||||

在图中我们可以看到,已知灰色部分 {2,3} 是 `非频繁项集`,那么利用上面的知识,我们就可以知道 {0,2,3} {1,2,3} {0,1,2,3} 都是 `非频繁的`。

|

||||

也就是说,计算出 {2,3} 的支持度,知道它是 `非频繁` 的之后,就不需要再计算 {0,2,3} {1,2,3} {0,1,2,3} 的支持度,因为我们知道这些集合不会满足我们的要求。

|

||||

使用该原理就可以避免项集数目的指数增长,从而在合理的时间内计算出频繁项集。

|

||||

|

||||

Apriori 算法优缺点

|

||||

|

||||

```

|

||||

* 优点: 易编码实现

|

||||

* 缺点: 在大数据集上可能较慢

|

||||

* 适用数据类型: 数值型 或者 标称型数据。

|

||||

```

|

||||

|

||||

Apriori 算法流程步骤:

|

||||

|

||||

```

|

||||

* 收集数据: 使用任意方法。

|

||||

* 准备数据: 任何数据类型都可以,因为我们只保存集合。

|

||||

* 分析数据: 使用任意方法。

|

||||

* 训练数据: 使用Apiori算法来找到频繁项集。

|

||||

* 测试算法: 不需要测试过程。

|

||||

* 使用算法: 用于发现频繁项集以及物品之间的关联规则。

|

||||

```

|

||||

|

||||

## Apriori 算法的使用

|

||||

前面提到,关联分析的目标包括两项: 发现 `频繁项集` 和发现 `关联规则`。

|

||||

首先需要找到 `频繁项集`,然后才能发现 `关联规则`。

|

||||

`Apriori` 算法是发现 `频繁项集` 的一种方法。

|

||||

Apriori 算法的两个输入参数分别是最小支持度和数据集。

|

||||

该算法首先会生成所有单个物品的项集列表。

|

||||

接着扫描交易记录来查看哪些项集满足最小支持度要求,那些不满足最小支持度要求的集合会被去掉。

|

||||

燃尽后对生下来的集合进行组合以声场包含两个元素的项集。

|

||||

接下来再重新扫描交易记录,去掉不满足最小支持度的项集。

|

||||

该过程重复进行直到所有项集被去掉。

|

||||

|

||||

### 生成候选项集

|

||||

|

||||

下面会创建一个用于构建初始集合的函数,也会创建一个通过扫描数据集以寻找交易记录子集的函数,

|

||||

数据扫描的伪代码如下:

|

||||

* 对数据集中的每条交易记录 tran

|

||||

* 对每个候选项集 can

|

||||

* 检查一下 can 是否是 tran 的子集: 如果是则增加 can 的计数值

|

||||

* 对每个候选项集

|

||||

* 如果其支持度不低于最小值,则保留该项集

|

||||

* 返回所有频繁项集列表

|

||||

以下是一些辅助函数。

|

||||

|

||||

#### 加载数据集

|

||||

|

||||

```python

|

||||

# 加载数据集

|

||||

def loadDataSet():

|

||||

return [[1, 3, 4], [2, 3, 5], [1, 2, 3, 5], [2, 5]]

|

||||

```

|

||||

|

||||

#### 创建集合 C1。即对 dataSet 进行去重,排序,放入 list 中,然后转换所有的元素为 frozenset

|

||||

|

||||

```python

|

||||

# 创建集合 C1。即对 dataSet 进行去重,排序,放入 list 中,然后转换所有的元素为 frozenset

|

||||

def createC1(dataSet):

|

||||

"""createC1(创建集合 C1)

|

||||

|

||||

Args:

|

||||

dataSet 原始数据集

|

||||

Returns:

|

||||

frozenset 返回一个 frozenset 格式的 list

|

||||

"""

|

||||

|

||||

C1 = []

|

||||

for transaction in dataSet:

|

||||

for item in transaction:

|

||||

if not [item] in C1:

|

||||

# 遍历所有的元素,如果不在 C1 出现过,那么就 append

|

||||

C1.append([item])

|

||||

# 对数组进行 `从小到大` 的排序

|

||||

print 'sort 前=', C1

|

||||

C1.sort()

|

||||

# frozenset 表示冻结的 set 集合,元素无改变;可以把它当字典的 key 来使用

|

||||

print 'sort 后=', C1

|

||||

print 'frozenset=', map(frozenset, C1)

|

||||

return map(frozenset, C1)

|

||||

```

|

||||

|

||||

#### 计算候选数据集 CK 在数据集 D 中的支持度,并返回支持度大于最小支持度(minSupport)的数据

|

||||

|

||||

```python

|

||||

# 计算候选数据集 CK 在数据集 D 中的支持度,并返回支持度大于最小支持度(minSupport)的数据

|

||||

def scanD(D, Ck, minSupport):

|

||||

"""scanD(计算候选数据集 CK 在数据集 D 中的支持度,并返回支持度大于最小支持度 minSupport 的数据)

|

||||

|

||||

Args:

|

||||

D 数据集

|

||||

Ck 候选项集列表

|

||||

minSupport 最小支持度

|

||||

Returns:

|

||||

retList 支持度大于 minSupport 的集合

|

||||

supportData 候选项集支持度数据

|

||||

"""

|

||||

|

||||

# ssCnt 临时存放选数据集 Ck 的频率. 例如: a->10, b->5, c->8

|

||||

ssCnt = {}

|

||||

for tid in D:

|

||||

for can in Ck:

|

||||

# s.issubset(t) 测试是否 s 中的每一个元素都在 t 中

|

||||

if can.issubset(tid):

|

||||

if not ssCnt.has_key(can):

|

||||

ssCnt[can] = 1

|

||||

else:

|

||||

ssCnt[can] += 1

|

||||

numItems = float(len(D)) # 数据集 D 的数量

|

||||

retList = []

|

||||

supportData = {}

|

||||

for key in ssCnt:

|

||||

# 支持度 = 候选项(key)出现的次数 / 所有数据集的数量

|

||||

support = ssCnt[key]/numItems

|

||||

if support >= minSupport:

|

||||

# 在 retList 的首位插入元素,只存储支持度满足频繁项集的值

|

||||

retList.insert(0, key)

|

||||

# 存储所有的候选项(key)和对应的支持度(support)

|

||||

supportData[key] = support

|

||||

return retList, supportData

|

||||

```

|

||||

|

||||

完整代码地址: <https://github.com/apachecn/AiLearning/blob/master/src/py2.x/ml/11.Apriori/apriori.py>

|

||||

|

||||

### 组织完整的 Apriori 算法

|

||||

|

||||

#### 输入频繁项集列表 Lk 与返回的元素个数 k,然后输出所有可能的候选项集 Ck

|

||||

|

||||

```python

|

||||

# 输入频繁项集列表 Lk 与返回的元素个数 k,然后输出所有可能的候选项集 Ck

|

||||

def aprioriGen(Lk, k):

|

||||

"""aprioriGen(输入频繁项集列表 Lk 与返回的元素个数 k,然后输出候选项集 Ck。

|

||||

例如: 以 {0},{1},{2} 为输入且 k = 2 则输出 {0,1}, {0,2}, {1,2}. 以 {0,1},{0,2},{1,2} 为输入且 k = 3 则输出 {0,1,2}

|

||||

仅需要计算一次,不需要将所有的结果计算出来,然后进行去重操作

|

||||

这是一个更高效的算法)

|

||||

|

||||

Args:

|

||||

Lk 频繁项集列表

|

||||

k 返回的项集元素个数(若元素的前 k-2 相同,就进行合并)

|

||||

Returns:

|

||||

retList 元素两两合并的数据集

|

||||

"""

|

||||

|

||||

retList = []

|

||||

lenLk = len(Lk)

|

||||

for i in range(lenLk):

|

||||

for j in range(i+1, lenLk):

|

||||

L1 = list(Lk[i])[: k-2]

|

||||

L2 = list(Lk[j])[: k-2]

|

||||

# print '-----i=', i, k-2, Lk, Lk[i], list(Lk[i])[: k-2]

|

||||

# print '-----j=', j, k-2, Lk, Lk[j], list(Lk[j])[: k-2]

|

||||

L1.sort()

|

||||

L2.sort()

|

||||

# 第一次 L1,L2 为空,元素直接进行合并,返回元素两两合并的数据集

|

||||

# if first k-2 elements are equal

|

||||

if L1 == L2:

|

||||

# set union

|

||||

# print 'union=', Lk[i] | Lk[j], Lk[i], Lk[j]

|

||||

retList.append(Lk[i] | Lk[j])

|

||||

return retList

|

||||

```

|

||||

|

||||

#### 找出数据集 dataSet 中支持度 >= 最小支持度的候选项集以及它们的支持度。即我们的频繁项集。

|

||||

|

||||

```python

|

||||

# 找出数据集 dataSet 中支持度 >= 最小支持度的候选项集以及它们的支持度。即我们的频繁项集。

|

||||

def apriori(dataSet, minSupport=0.5):

|

||||

"""apriori(首先构建集合 C1,然后扫描数据集来判断这些只有一个元素的项集是否满足最小支持度的要求。那么满足最小支持度要求的项集构成集合 L1。然后 L1 中的元素相互组合成 C2,C2 再进一步过滤变成 L2,然后以此类推,知道 CN 的长度为 0 时结束,即可找出所有频繁项集的支持度。)

|

||||

|

||||

Args:

|

||||

dataSet 原始数据集

|

||||

minSupport 支持度的阈值

|

||||

Returns:

|

||||

L 频繁项集的全集

|

||||

supportData 所有元素和支持度的全集

|

||||

"""

|

||||

# C1 即对 dataSet 进行去重,排序,放入 list 中,然后转换所有的元素为 frozenset

|

||||

C1 = createC1(dataSet)

|

||||

# 对每一行进行 set 转换,然后存放到集合中

|

||||

D = map(set, dataSet)

|

||||

print 'D=', D

|

||||

# 计算候选数据集 C1 在数据集 D 中的支持度,并返回支持度大于 minSupport 的数据

|

||||

L1, supportData = scanD(D, C1, minSupport)

|

||||

# print "L1=", L1, "\n", "outcome: ", supportData

|

||||

|

||||

# L 加了一层 list, L 一共 2 层 list

|

||||

L = [L1]

|

||||

k = 2

|

||||

# 判断 L 的第 k-2 项的数据长度是否 > 0。第一次执行时 L 为 [[frozenset([1]), frozenset([3]), frozenset([2]), frozenset([5])]]。L[k-2]=L[0]=[frozenset([1]), frozenset([3]), frozenset([2]), frozenset([5])],最后面 k += 1

|

||||

while (len(L[k-2]) > 0):

|

||||

print 'k=', k, L, L[k-2]

|

||||

Ck = aprioriGen(L[k-2], k) # 例如: 以 {0},{1},{2} 为输入且 k = 2 则输出 {0,1}, {0,2}, {1,2}. 以 {0,1},{0,2},{1,2} 为输入且 k = 3 则输出 {0,1,2}

|

||||

print 'Ck', Ck

|

||||

|

||||

Lk, supK = scanD(D, Ck, minSupport) # 计算候选数据集 CK 在数据集 D 中的支持度,并返回支持度大于 minSupport 的数据

|

||||

# 保存所有候选项集的支持度,如果字典没有,就追加元素,如果有,就更新元素

|

||||

supportData.update(supK)

|

||||

if len(Lk) == 0:

|

||||

break

|

||||

# Lk 表示满足频繁子项的集合,L 元素在增加,例如:

|

||||

# l=[[set(1), set(2), set(3)]]

|

||||

# l=[[set(1), set(2), set(3)], [set(1, 2), set(2, 3)]]

|

||||

L.append(Lk)

|

||||

k += 1

|

||||

# print 'k=', k, len(L[k-2])

|

||||

return L, supportData

|

||||

```

|

||||

|

||||

到这一步,我们就找出我们所需要的 `频繁项集` 和他们的 `支持度` 了,接下来再找出关联规则即可!

|

||||

|

||||

完整代码地址: <https://github.com/apachecn/AiLearning/blob/master/src/py2.x/ml/11.Apriori/apriori.py>

|

||||

|

||||

## 从频繁项集中挖掘关联规则

|

||||

|

||||

前面我们介绍了用于发现 `频繁项集` 的 Apriori 算法,现在要解决的问题是如何找出 `关联规则`。

|

||||

|

||||

要找到 `关联规则`,我们首先从一个 `频繁项集` 开始。

|

||||

我们知道集合中的元素是不重复的,但我们想知道基于这些元素能否获得其它内容。

|

||||

某个元素或某个元素集合可能会推导出另一个元素。

|

||||

从先前 `杂货店` 的例子可以得到,如果有一个频繁项集 {豆奶,莴苣},那么就可能有一条关联规则 “豆奶 -> 莴苣”。

|

||||

这意味着如果有人买了豆奶,那么在统计上他会购买莴苣的概率比较大。

|

||||

但是,这一条件反过来并不总是成立。

|

||||

也就是说 “豆奶 -> 莴苣” 统计上显著,那么 “莴苣 -> 豆奶” 也不一定成立。

|

||||

|

||||

前面我们给出了 `频繁项集` 的量化定义,即它满足最小支持度要求。

|

||||

对于 `关联规则`,我们也有类似的量化方法,这种量化指标称之为 `可信度`。

|

||||

一条规则 A -> B 的可信度定义为 support(A | B) / support(A)。(注意: 在 python 中 | 表示集合的并操作,而数学书集合并的符号是 U)。

|

||||

`A | B` 是指所有出现在集合 A 或者集合 B 中的元素。

|

||||

由于我们先前已经计算出所有 `频繁项集` 的支持度了,现在我们要做的只不过是提取这些数据做一次除法运算即可。

|

||||

|

||||

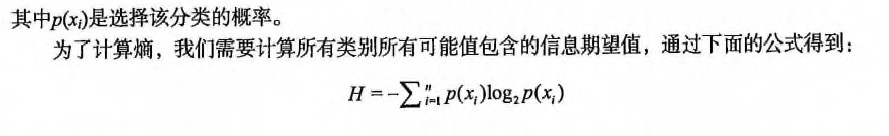

### 一个频繁项集可以产生多少条关联规则呢?

|

||||

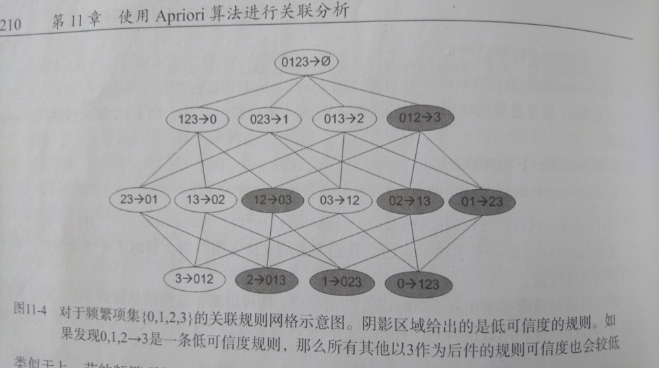

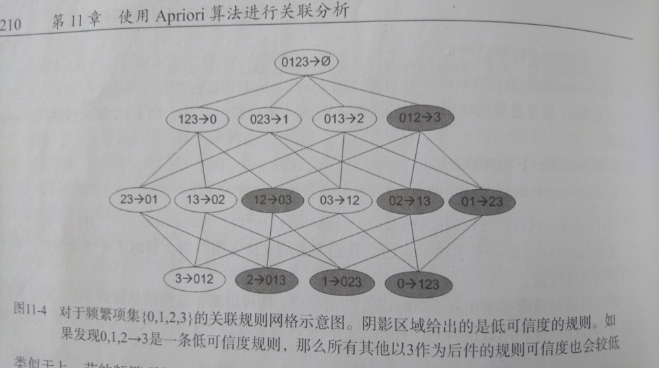

如下图所示,给出的是项集 {0,1,2,3} 产生的所有关联规则:

|

||||

|

||||

与我们前面的 `频繁项集` 生成一样,我们可以为每个频繁项集产生许多关联规则。

|

||||

如果能减少规则的数目来确保问题的可解析,那么计算起来就会好很多。

|

||||

通过观察,我们可以知道,如果某条规则并不满足 `最小可信度` 要求,那么该规则的所有子集也不会满足 `最小可信度` 的要求。

|

||||

如上图所示,假设 `123 -> 3` 并不满足最小可信度要求,那么就知道任何左部为 {0,1,2} 子集的规则也不会满足 `最小可信度` 的要求。

|

||||

即 `12 -> 03` , `02 -> 13` , `01 -> 23` , `2 -> 013`, ` 1 -> 023`, `0 -> 123` 都不满足 `最小可信度` 要求。

|

||||

|

||||

可以利用关联规则的上述性质属性来减少需要测试的规则数目,跟先前 Apriori 算法的套路一样。

|

||||

以下是一些辅助函数:

|

||||

|

||||

#### 计算可信度

|

||||

|

||||

```python

|

||||

# 计算可信度(confidence)

|

||||

def calcConf(freqSet, H

|

||||

, supportData, brl, minConf=0.7):

|

||||

"""calcConf(对两个元素的频繁项,计算可信度,例如: {1,2}/{1} 或者 {1,2}/{2} 看是否满足条件)

|

||||

|

||||

Args:

|

||||

freqSet 频繁项集中的元素,例如: frozenset([1, 3])

|

||||

H 频繁项集中的元素的集合,例如: [frozenset([1]), frozenset([3])]

|

||||

supportData 所有元素的支持度的字典

|

||||

brl 关联规则列表的空数组

|

||||

minConf 最小可信度

|

||||

Returns:

|

||||

prunedH 记录 可信度大于阈值的集合

|

||||

"""

|

||||

# 记录可信度大于最小可信度(minConf)的集合

|

||||

prunedH = []

|

||||

for conseq in H: # 假设 freqSet = frozenset([1, 3]), H = [frozenset([1]), frozenset([3])],那么现在需要求出 frozenset([1]) -> frozenset([3]) 的可信度和 frozenset([3]) -> frozenset([1]) 的可信度

|

||||

|

||||

# print 'confData=', freqSet, H, conseq, freqSet-conseq

|

||||

conf = supportData[freqSet]/supportData[freqSet-conseq] # 支持度定义: a -> b = support(a | b) / support(a). 假设 freqSet = frozenset([1, 3]), conseq = [frozenset([1])],那么 frozenset([1]) 至 frozenset([3]) 的可信度为 = support(a | b) / support(a) = supportData[freqSet]/supportData[freqSet-conseq] = supportData[frozenset([1, 3])] / supportData[frozenset([1])]

|

||||

if conf >= minConf:

|

||||

# 只要买了 freqSet-conseq 集合,一定会买 conseq 集合(freqSet-conseq 集合和 conseq 集合是全集)

|

||||

print freqSet-conseq, '-->', conseq, 'conf:', conf

|

||||

brl.append((freqSet-conseq, conseq, conf))

|

||||

prunedH.append(conseq)

|

||||

return prunedH

|

||||

````

|

||||

|

||||

#### 递归计算频繁项集的规则

|

||||

|

||||

```python

|

||||

# 递归计算频繁项集的规则

|

||||

def rulesFromConseq(freqSet, H, supportData, brl, minConf=0.7):

|

||||

"""rulesFromConseq

|

||||

|

||||

Args:

|

||||

freqSet 频繁项集中的元素,例如: frozenset([2, 3, 5])

|

||||

H 频繁项集中的元素的集合,例如: [frozenset([2]), frozenset([3]), frozenset([5])]

|

||||

supportData 所有元素的支持度的字典

|

||||

brl 关联规则列表的数组

|

||||

minConf 最小可信度

|

||||

"""

|

||||

# H[0] 是 freqSet 的元素组合的第一个元素,并且 H 中所有元素的长度都一样,长度由 aprioriGen(H, m+1) 这里的 m + 1 来控制

|

||||

# 该函数递归时,H[0] 的长度从 1 开始增长 1 2 3 ...

|

||||

# 假设 freqSet = frozenset([2, 3, 5]), H = [frozenset([2]), frozenset([3]), frozenset([5])]

|

||||

# 那么 m = len(H[0]) 的递归的值依次为 1 2

|

||||

# 在 m = 2 时, 跳出该递归。假设再递归一次,那么 H[0] = frozenset([2, 3, 5]),freqSet = frozenset([2, 3, 5]) ,没必要再计算 freqSet 与 H[0] 的关联规则了。

|

||||

m = len(H[0])

|

||||

if (len(freqSet) > (m + 1)):

|

||||

print 'freqSet******************', len(freqSet), m + 1, freqSet, H, H[0]

|

||||

# 生成 m+1 个长度的所有可能的 H 中的组合,假设 H = [frozenset([2]), frozenset([3]), frozenset([5])]

|

||||

# 第一次递归调用时生成 [frozenset([2, 3]), frozenset([2, 5]), frozenset([3, 5])]

|

||||

# 第二次 。。。没有第二次,递归条件判断时已经退出了

|

||||

Hmp1 = aprioriGen(H, m+1)

|

||||

# 返回可信度大于最小可信度的集合

|

||||

Hmp1 = calcConf(freqSet, Hmp1, supportData, brl, minConf)

|

||||

print 'Hmp1=', Hmp1

|

||||

print 'len(Hmp1)=', len(Hmp1), 'len(freqSet)=', len(freqSet)

|

||||

# 计算可信度后,还有数据大于最小可信度的话,那么继续递归调用,否则跳出递归

|

||||

if (len(Hmp1) > 1):

|

||||

print '----------------------', Hmp1

|

||||

# print len(freqSet), len(Hmp1[0]) + 1

|

||||

rulesFromConseq(freqSet, Hmp1, supportData, brl, minConf)

|

||||

```

|

||||

|

||||

#### 生成关联规则

|

||||

|

||||

```python

|

||||

# 生成关联规则

|

||||

def generateRules(L, supportData, minConf=0.7):

|

||||

"""generateRules

|

||||

|

||||

Args:

|

||||

L 频繁项集列表

|

||||

supportData 频繁项集支持度的字典

|

||||

minConf 最小置信度

|

||||

Returns:

|

||||

bigRuleList 可信度规则列表(关于 (A->B+置信度) 3个字段的组合)

|

||||

"""

|

||||

bigRuleList = []

|

||||

# 假设 L = [[frozenset([1]), frozenset([3]), frozenset([2]), frozenset([5])], [frozenset([1, 3]), frozenset([2, 5]), frozenset([2, 3]), frozenset([3, 5])], [frozenset([2, 3, 5])]]

|

||||

for i in range(1, len(L)):

|

||||

# 获取频繁项集中每个组合的所有元素

|

||||

for freqSet in L[i]:

|

||||

# 假设: freqSet= frozenset([1, 3]), H1=[frozenset([1]), frozenset([3])]

|

||||

# 组合总的元素并遍历子元素,并转化为 frozenset 集合,再存放到 list 列表中

|

||||

H1 = [frozenset([item]) for item in freqSet]

|

||||

# 2 个的组合,走 else, 2 个以上的组合,走 if

|

||||

if (i > 1):

|

||||

rulesFromConseq(freqSet, H1, supportData, bigRuleList, minConf)

|

||||

else:

|

||||

calcConf(freqSet, H1, supportData, bigRuleList, minConf)

|

||||

return bigRuleList

|

||||

```

|

||||

|

||||

到这里为止,通过调用 generateRules 函数即可得出我们所需的 `关联规则`。

|

||||

|

||||

* 分级法: 频繁项集->关联规则

|

||||

* 1.首先从一个频繁项集开始,接着创建一个规则列表,其中规则右部分只包含一个元素,然后对这个规则进行测试。

|

||||

* 2.接下来合并所有剩余规则来创建一个新的规则列表,其中规则右部包含两个元素。

|

||||

* 如下图:

|

||||

*

|

||||

* 最后: 每次增加频繁项集的大小,Apriori 算法都会重新扫描整个数据集,是否有优化空间呢? 下一章: FP-growth算法等着你的到来

|

||||

|

||||

* * *

|

||||